BIO – Medicina Costruzione Sociale nella Post-Modernità – Educational Papers • Anno VII • Numero 25 • Marzo 2018

Scritto in collaborazione con Eugenia D’Alterio – biologa

Non siamo più solo noi umani a compiere processi cognitivi e di apprendimento complessi

Stiamo sempre più accumulando dati ad un’incredibile velocità. Ad esempio, ogni esperimento con la microscopia elettronica, per esplorare quei complessi macromolecolari che chiamiamo ribosomi,1 La loro funzione è quella di leggere le informazioni contenute nella catena di RNA messaggero (m-RNA). Detto in un altro modo, in biologia, ciascuna delle particelle ricche di acido ribonucleico presenti in gran numero nel citoplasma cellulare. I ribosomi sono i siti ove avviene il processo di traduzione del messaggio genetico portato dall’RNA messaggero, cioè la sintesi proteica. ha generato diversi terabyte2 di dati che sono stati manipolati, analizzati, ridotti e, infine, conformati in un modello di struttura comprensibile ed utile al nostro processo cognitivo basato sui pattern. Ma la ricerca è andata avanti tanto che il Nobel per la chimica 2017 è stato assegnato alla crio-microscopia elettronica, tecnica che ha superato le difficoltà incontrate nello studio di materiale biologico con la microscopia elettronica convenzionale.3 Si iniziò a superare l’ostacolo verso la metà degli anni settanta, grazie agli studi di Richard Henderson che all’Università di Cambridge ottenne un’immagine tridimensionale di una molecola biologica. Si trattava della rodopsina, una proteina che si trova avvolta in una membrana in organismi sensibili alla luce. Proprio la membrana e una soluzione di zucchero, glucosio per la precisione, applicata dai ricercatori proteggeva la proteina dai danni del vuoto, un fascio elettronico di limitata potenza fece poi il resto. Come risultato furono ottenute immagini con una risoluzione sufficiente a ricostruire, per la prima volta, la struttura tridimensionale della rodopsina. Negli anni successivi, le tecniche di microscopia elettronica migliorarono al punto da rendere possibile la ricostruzione della stessa struttura con una risoluzione atomica. Il risultato fu presentato da Henderson nel 1990. L’idea di Henderson per prevenire la disidratazione dei campioni prevedeva l’uso di una soluzione di glucosio, che però non era adatta per molecole biologiche solubili in acqua. Altri ricercatori avevano tentato di congelare i campioni, puntando sul fatto che il ghiaccio evapora più lentamente dell’acqua liquida. Il problema però era che i cristalli di ghiaccio alteravano il fascio di elettroni fino a renderlo inutilizzabile. La soluzione del problema venne da Jacques Dubochet: raffreddare l’acqua così rapidamente da non dare tempo ai cristalli di formarsi. Le molecole di acqua potevano così rimanere in uno stato disordinato, simile a quello del vetro. Già nel 1982, il gruppo di Debouchet riuscì a “vetrificare” goccioline di acqua in etano portate alla temperatura di -196 °C. Dopo questo fondamentale traguardo, il ricercatore svizzero si dedicò a sviluppare una tecnica che sarebbe diventata la base della crio-microscopia elettronica. Iniziò a sciogliere i campioni biologici da osservare in acqua, che veniva successivamente vetrificata. E nel 1984 pubblicò le prime immagini di virus di diverse forme e strutture. Compiuto questo primo passo, non restava che trovare come applicarlo in modo più diffuso. Joachim Frank, del New York State Department of Health, cercava per via teorica il modo di ottenere immagini tridimensionali a elevata risoluzione da immagini bidimensionali a bassa risoluzione ottenute con la microscopia elettronica. Frank riuscì a sviluppare un algoritmo matematico che consentisse a un computer di identificare schemi e figure ricorrenti all’interno di diverse immagini, rendendo molto più nitido il risultato finale. Questo obiettivo fu raggiunto da Frank già nel 1981, e già verso la metà degli anni ottanta il metodo era pronto per il grande salto: ottenere immagini tridimensionali. Per dimostrare le potenzialità del metodo, il ricercatore scelse il ribosoma, la gigantesca macchina molecolare responsabile della sintesi delle proteine all’interno della cellula: l’immagine tridimensionale della sua superficie stupì il mondo. Nel 1991, preparando il ribosoma secondo la tecnica criogenica di Debouchet, Frank ottenne immagini con una risoluzione di 40 angstrom (un angstrom corrisponde a 0,1 nanometri oppure a dieci alla meno dieci metri, o a un decimiliardesimo di metro). Con nuove metodiche di rivelazione degli elettroni, la risoluzione è arrivata in anni recenti alla scala del singolo atomo. Ora la crio-microscopia elettronica è una realtà tecnologica a disposizione di molti laboratori nel mondo e ha permesso una rivoluzione della biochimica, perché permette di ottenere, come in un film, diverse istantanee di processi chimici che si svolgono alle scale atomiche e nell’arco di frazioni di miliardesimi di secondo.

In particolare, con queste analisi o costruzione dei dati, pensiamo di sapere cosa accade in queste particelle ricche di acido ribonucleico che chiamiamo ribosomi e, in questo modo, ci formiamo una certa idea di cosa facciano i programmi, di quali siano gli algoritmi, di come si elaborino i risultati e, quindi, ci sentiamo, intellettualmente, capaci di capirne conclusioni ed esiti.

Nella società contemporanea, tuttavia, non siamo più solo noi umani a compiere “processi, cognitivi” e di apprendimento, complessi. Ciò che sta accadendo in molti campi, compreso quello della biologia, è che la nostra sempre più avanzata tecnologia ci ha permesso di disporre dell’apprendimento automatico4 [machine learning], in cui i computer sono, essenzialmente, impostati a riconoscere pattern [modelli] con reti neurali artificiali profonde.5 Queste Intelligenze Artificiali, quindi, stanno riformulando regole basate su dimensioni inimmaginabili di pattern (modelli). Ci sono algoritmi statistici che consentono di dare pesi e misure a varie aspetti o fattori e, alla fine, giungere a conclusioni.

Quando questi computer [o meglio, Intelligenze Artificiali] presentano queste conclusioni, noi, come classe media, non abbiamo un’idea precisa e dettagliata di come ciò velocemente accada, abbiamo solo un’idea del processo in generale. Se le Intelligenze Artificiali mostrano una qualsivoglia correlazione, noi non ne comprendiamo i processi nello stesso modo in cui li avremmo compresi se fossimo stati noi stessi a stabilirla in base ad un “algoritmo intellettuale naturale”. Quindi, siamo in una situazione in cui ci stiamo chiedendo: come noi comprendiamo i risultati che derivano dalle analisi delle Intelligenze Artificiali? Consideriamo che ciò accadrà sempre di più in quanto i set di dati inseriti diventano più grandi, perché più ampi sono gli studi sul genoma, gli studi di popolazione e di tutti i tipi di tassonomie e classificazioni. Forse noi, come gente comune, non comprendiamo questi processi perché non analizziamo a fondo che siamo già inseriti in una tecnologia che ci sovrasta, basti pensare all’utilizzo di smartphone e tablet sempre più sofisticati ma che tutti noi utilizziamo senza conoscerne i processi.

Sviluppo della conoscenza sui ribosomi mediante intelligenze artificiali

Tornando al ribosoma, come in tante altre discipline, gli studiosi, a riguardo, servendosi di Intelligenze Artificiali, pensano di essere sulla soglia di una nuova era della biologia strutturale, dove gli ostacoli ai traguardi ambiti, creduti per decenni insormontabili, stanno crollando. In effetti, ora si sta imparando molto di più circa le componenti ultrastrutturali delle cellule. Il vero avanzamento è che si potrà guardare a tutti i componenti e ai grandi complessi molecolari all’interno della cellula con metodiche sempre più precise e ciò ci dirà molto di più sulla già dettagliata organizzazione e funzionamento molecolare della cellula. Inoltre, queste analisi, sempre più precise sul funzionamento cellulare, ci permetteranno di sconfiggere, sempre più, malattie congenite, genomiche e processi oncologici, e produrre nuovi farmaci.

Infatti, per quasi tutte le malattie c’è uno scompenso di un processo metabolico fondamentale che la sta “causando”. Questo scompenso o deregolamentazione di un processo può essere sia causale, o impostato geneticamente. Comprendere i processi infinitesimali nella cellula, in termini molecolari e sotto molecolari, si ipotizza, ci darebbero tutte le modalità per curare le malattie specifiche, e nuovi bersagli per cure più evolute. L’impatto sulla medicina, in generale, porteebbe ad una precisione maggiore nel lungo periodo.

Ci sono diversi tipi di domande che gli studiosi della biologia si pongono, oggi. Alcuni di questi ricercatori, come il Nobel per la chimica 2009, Venkatraman Ramakrishnan,6 si interrogano, in particolare, su questioni legate alla struttura e funzione dei ribosomi. Il ribosoma è questo grande “macchinario” molecolare che legge i nostri geni e traduce le informazioni in proteine.7 Una delle grandi scoperte, quindici anni fa circa, è stata quella di poter osservare i dettagli atomici di questo macchinario per la prima volta. Quindi, man mano, dall’identificazione del ribosoma, abbiamo avuto un primo sguardo di quello che costituisce il modello del ribosoma, sia in termini strutturali che chimici, fino ad arrivare, oggi (torna a nota 1, sui Ribosomi), a capirne la sua piena funzionalità.

Ma come vengono regolati? La cellula può regolare l’attività del ribosoma richiedendo (segnali molecolari) al ribosoma di iniziare a produrre determinate proteine, e, poi, di inattivare questa funzione.8 Se il ribosoma non è regolamentato correttamente, può portare a malattie come il cancro. Inoltre, molte malattie genetiche umane mostrano i loro difetti nei ribosomi mitocondriali. I virus, (come quelli per l’epatite C) e altri microrganismi, possono sfruttare il ribosoma facendo smettere la produzione di proteine della cellula ospite promuovendo la produzione delle proprie proteine. Come questi virus dirottano il “macchinario” di traslazione, sono procedure che gli studiosi dei ribosomi hanno chiarito.

È ironico, oggi, pensare che Venkatraman Ramakrishnan sia diventato noto per la definizione di alcune delle prime strutture atomiche dei ribosomi, di sottosezioni ribosomali e, quindi, dell’intero ribosoma, utilizzando una vecchia tecnica di decenni fa, cioè la cristallografia a raggi X.9 Anche la versione macromolecolare di questa ricercata struttura atomica, fatta da Max Perutz e John Kendrew10 al famoso MRC (Medical Research Council) Laboratory of Molecular Biology (LMB),11 a Cambridge (UK), è stata fatta tra i primi anni ‘50 e ‘60 del secolo scorso. Anche questa tecnica aveva almeno quarant’anni, quando Venkatraman Ramakrishnan e i suoi colleghi iniziarono a decifrare le strutture dei ribosomi. L’ironia è che sono stati conosciuti per aver usato questa tecnica abbastanza stabilita ma allungandola nei suoi limiti per risolvere qualcosa che fosse dell’ordine di un milione di atomi. Ma nessuno risolverebbe, oggi, la questione dei ribosomi utilizzando una tale tecnica.

Nello stesso Laboratorio di Biologia Molecolare, a Cambridge, che ha introdotto la cristallografia a raggi X delle proteine, un’altra tecnica è affiorata in tutto il mondo. Il MRC (Medical Research Council) ha guidato molti avanzamenti guardando alla cristallografia delle proteine12 con la microscopia elettronica. Ciò richiede meno materiale biologico e permette di ottenere “istantanee” del ribosoma umano e di ogni sorta di materiale biologico.

Se qualcuno dovesse descrivere quello per cui Venkatraman Ramakrishnan sia diventato noto, sarebbe come descrivere qualcuno che ha sviluppato la Betamax.13 C’è un libro sui computer chiamato Soul of a New Machine da Tracy Kidder,[efn-note]Tracy Kidder. Soul of a New Machine. Back Bay Books, New York, 2000.[/efn_note] che tratta circa un computer di dati generali (General Data) che sarebbe stato un passo superiore a qualsiasi cosa esistesse all’epoca. Ironia della sorte, quel computer non è mai decollato. Alcuni anni dopo la sua uscita, è stato sostituito dalla serie VAX di computer che avrebbe rivoluzionato il sistema di ricerca sui ribosomi.14

Reti neurali artificiali

Ci sono, così, tanti problemi di scala dipendenti dai grandi dataset15 che, paradossalmente, ci stiamo, sempre più, allontanando dai dati stessi, dal momento che questo intermediario, l’Intelligenza Artificiale, fa l’analisi per noi. Per alcuni studiosi, come Venkatraman Ramakrishnan, questo significa un cambiamento nel nostro modo di conoscere, di capire, ad esempio, le correlazione tra elementi, dati o fenomeni. Se qualcuno ci chiedesse come si è arrivati alle conclusioni delle intelligenze artificiali, non possiamo che dire che il sistema ha analizzato mega dati per arrivare a certe correlazioni o, al più, che forse la relazione stabilita dall’Intelligenza Artificiale significa A o, forse, B. Ciò è, epistemologicamente, diverso dal modo in cui abbiamo stabilito le correlazioni fino ad oggi.

Ora, Internet e il World Wide Web16 permettono di usufruire di un gran numero di informazioni e collegarci, in tempo reale, a grande vantaggio per ricercatori e noi mass media. Si pensi solo che 60 o 70 anni fa, se si voleva procurarsi un libro e si viveva fuori dal perimetro delle grandi città, il suo arrivo avrebbe comportato mesi dopo la pubblicazione. Infatti, le riviste arrivavano per posta, al più, mesi dopo. Oggi, si ha accesso alle informazioni, anche se non tutte affidabili via web, con accessibilità a corsi e di ascolto di conferenze specifiche. Questo è un grande livellamento positivo sul campo.

Ma, oltre ai vantaggi, ciò che è accaduto è un enorme rumore,17 un eccesso di informazione, il più delle volte non affidabile, a causa di chi propone, in un gergo pseudo-scientifico, le proprie idee, in ogni campo, di chi esprime il proprio discorso in gergo tecnico, parlando di tutto senza una preparazione specifica. Questi dati, a volte senza senso, al grande pubblico sembrano attendibili. La scienza è diventata così tecnica che è uno sforzo reale comunicarla a noi pubblico in modo accessibile e affidabile. Pubblico che è bombardato con informazioni in gran parte attendibili ma, a volte, ingannevoli. La realtà è che, anche nella scienza, vi sono tanti esperimenti errati o non necessari. Ad esempio, si pubblicano documenti con ricerche che sono stati ampiamente studiate e date per scontati. Ma, naturalmente, può succedere, quando la questione è stata ulteriormente approfondita, che i risultati precedenti possono risultare del tutto, inattendibili.

L’attenzione mediatica

Il primo “studio” o “inchiesta” su qualcosa di rilievo per la vita umana ottiene sempre molta notorietà mediatica. Le ricerche successive, che chiariscono la questione e mostrano che non c’è una tale problematica o che non c’è l’annunciato beneficio, non ottengono l’attenzione mediatica che conforma le nostre opinioni e comportamenti. Il pubblico ha, quindi, una visione distorta di ciò che è scientifico e ciò che non lo è. Il cittadino medio finisce per dire: “Beh, anche questo è stato pubblicato in un “giornale scientifico”. Ma, nella costruzione di una disciplina, o di una scienza, è necessario considerare il maggior numero di documentazioni sperimentali che provino o evidenziano il postulato o l’ipotesi in considerazione. Un tale discernimento sta diventando sempre più difficile per l’uomo medio e, addirittura, per lo scienziato al di fuori del proprio campo di ricerca.

Come fare, in qualità di comunità scientifica, ad affrontare questo problema e comunicare al pubblico un senso di ciò che la scienza è, di ciò che è affidabile, di ciò che è incerto e di ciò che è, semplicemente, sbagliato. Come spiegare che la comunità scientifica vive con l’incertezza. Gli scienziati sanno che non importa quanto fiduciosi siano nelle loro teorie, perché è possibile che si sbaglino, che le loro idee possano essere errate e devono essere preparati a questo. Ciò non vuol dire che le loro idee non dispongano di merito e che non debbano essere valutate. La problematica si pone in molti campi. Il cambiamento climatico, ad esempio, è un terreno classico in cui le incertezze nell’opinione consensuale vengono contrastate da persone che non la condividono e, pertanto, si oppongono ai rilievi scientifici.

Apprendimento automatico

Ciò che l’apprendimento automatico sta compiendo è straordinario. Se qualcuno ci avesse detto che i computer sarebbero stati programmati a fare le cose che fanno adesso – come battere il campione del mondo di GO,18 nessuno lo avrebbe mai pensato. Ma, andando da lì all’idea generale di sviluppare macchine di intelligenza artificiale che elaborino come un essere umano e sviluppino coscienza, ancora, rimane per noi a livello di fantascienza. In parte, ciò accade perché non conosciamo i processi umani a quel livello di dettaglio. Ad esempio: come facciamo a ricordare un numero di telefono e sa- pere di cosa si tratta? Come lo memorizziamo? Come lo associamo ad una persona , ad un nome? E come riconosciamo tutte le varianti personali associate a quel numero? Domande apparentemente semplici, ma le risposte comprendono una pluralità di questioni, dalla cognizione all’evocazione, alla memoria, a come una cellula cerebrale registra le informazioni e a come i neuroni elaborino, tutte questioni lontane dalla nostra quotidianità, ma di facile spiegazione per esperti del settore.

Addentrandoci nella questione, ogni campo di ricerca dovrebbe perfezionarsi per poter concordare un quadro comune di connessione. Oramai la tecnologia sforna, in continuazione, ogni tipo di prodotto, capace di svolgere ogni tipo di funzionalità e attività in ogni campo dal sanitario al meccanico (farmaci di nuova generazione, protesi sempre più sofisticate, auto senza conducente, configurazioni di pattern derivati dai grandi dataset, e così via).

Certo, noi, umani, tendiamo ad essere antropomorfici. Quando vediamo macchine fare cose che pensavamo che solo noi umani potessimo fare, come giocare a scacchi o a Go, improvvisamente, pensiamo di trovarci davanti a un regno di fantascienza che le macchine, da noi stessi costruite, sono in grado di attuare. Queste intelligenze artificiali sono programmate a fare cose più disparate, e potranno eseguire compiti incredibilmente sempre più complessi, ma saranno un sostitutivo del pensiero umano e della visione umana?

Difficile dare una risposta definitiva, anche perché noi umani, dovremmo progredire al progredire dell’appren- dimento automatico (l’intelligenza artificiale). Questo è un campo molto rilevante che richiede attenzione. L’intelligenza artificiale è una dimensione che dovrebbe interessare seriamente i giovani poiché riguarda il loro prossimo futuro. Scenari di androidi o robotica dovrebbero preoccupare di meno di computer così perfezionati da poter prendere il sopravvento sull’umano.

I ricercatori che lavorano, in tutto il mondo, nel campo dell’apprendimento automatico e dell’apprendimento profondo,19 per rendere i computer più avanzati in vista di sviluppare una sorta di intelligenza artificiale sovrumana o come la si voglia chiamare, dovrebbero farlo, esclusivamente, in un contesto di benessere per l’umanità, ma non sempre è così. Fortunatamente, se da un lato aumenta la ricerca sui prodotti artificiali, aumenta la ricerca sulla fisiologia umana, tant’è che la neuro-biologia è, davvero, decollata. Tutti i tipi di strumenti sono stati sviluppati per osservare quali neuroni stanno “collassando” per manipolarli geneticamente e vedere cosa succede in tempo reale con gli input. Ci sono stati, cosi, molti progressi nella biologia molecolare e nella neurobiologia, e se la neuroscienza studia l’evoluzione dei sistemi nervosi le ricerche interdisciplinari, correlate, sono fondamentali (biologia molecolare, genetica molecolare, chimica molecolare) alla loro progressione.

Infatti, al riguardo è inevitabile essere più in linea con la visione di Daniel Dennett, cioè che noi, umani, non comprendiamo, sufficientemente, la complessità del nostro cervello evoluto e quanto sia, incredibilmente, caratterizzata da funzioni di tipo logico e computazionale.

Ma se saremo sostituiti, come specie, sarà con organismi sempre resistenti e fiorenti sulla terra, come i batteri che possono vivere in qualsiasi condizione ambientale estrema. Per cui dobbiamo mettere in un contesto più ampio la domanda riguardo dove siamo diretti. Alla ricerca della costruzione di un senso del nostro domani possiamo dirci che non viviamo in un vuoto organico e non dovremmo imporre il vuoto metafisico al mondo organico e fisico.

Sviluppo della conoscenza sui ribosomi: migrazione dei fisici nel territorio della biologia

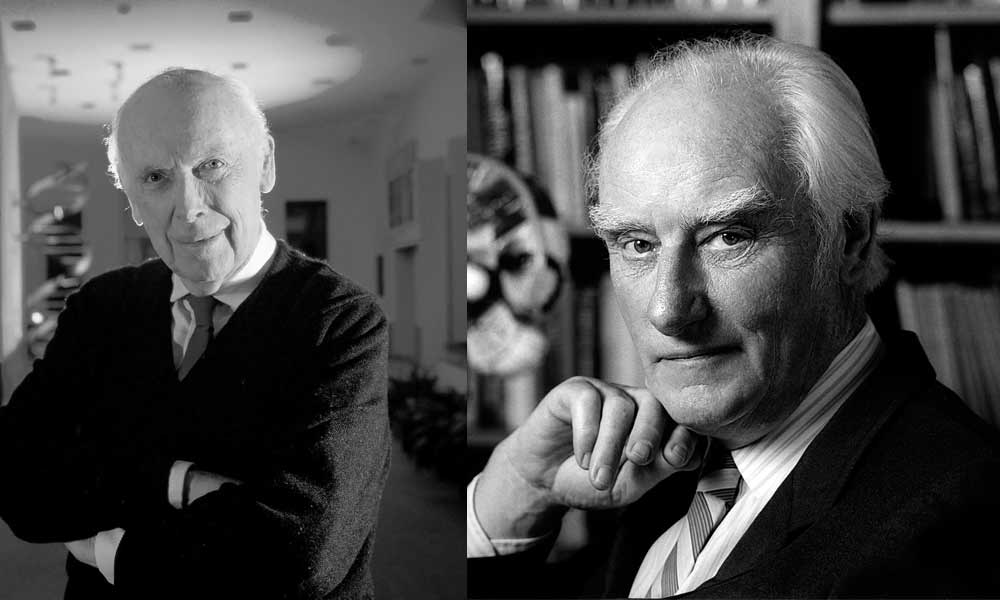

La svolta epocale nella biologia avvenne con la migrazione di fisici, come Francis Crick20 e Max Delbrück21 al territorio della biologia. Anche Venkatraman Ramakrishnan, le cui ricerche sulla struttura del ribosoma costituiscono l’ispirazione di questa argomentazione, è un altro di questi migranti dalla fisica alla biologia.

Donald M. Engelman22 & Peter Moore,23 nei loro esperimenti per visualizzare un modello della struttura del ribosoma utilizzarono una tecnica della fisica chiamata scattering di neutroni.24 Possiamo chiederci: perché preoccuparci di guardare la struttura del ribosoma? Semplicemente, per essere consapevoli che legge il messaggio genetico copiato dal DNA (che è, come sappiamo, una molecola a doppio filamento) su una singola stringa chiamata RNA messaggero, come un nastro di telescrivente.

Leggendo le informazioni, e basandosi su queste informazioni, il ribosoma mette insieme una catena proteica con, esattamente, l’ordine giusto di aminoacidi per ogni singolo tipo di proteina richiesta. Il ribosoma riconosce quando iniziare e quando fermarsi, ed è la cellula stessa a regolarne la funzione.

Come funzionava tutto il processo? Molti dei primi pionieri nel campo abbandonarono la ricerca. James Watson,25 ad esempio, smise di lavorare sui ribosomi e, anche, altri studiosi lo fecero. Ma un piccolo gruppo di ricercatori persisteva e la ragione era che volevano capire come funzionava il complesso ribosomiale. Quando Venkatraman Ramakrishnan andò a lavorare con Peter Moore, il loro lavoro di ricerca consisteva proprio nel rendere una mappa o modello della struttura del ribosoma. In laboratorio si ritrovarono con due constatazioni. La prima era che i dettagli della struttura ricercata non era a livello chimico, fondamentale per capire come il ribosoma attuasse quelle funzioni come riconoscere un codice trasportato dall’mRNA e unire gli aminoacidi in una proteina. La seconda osservazione era che il ribosoma si concentrava sulla produzione delle proteine.

Ma come è iniziata la ricerca sul ribosoma? Il primo indizio è venuto da Francis Crick, che formulò che, forse, i primi ribosomi sono stati costituiti interamente da solo RNA, e poi si sono evoluti nella più grande macchina di produzione di proteine. Quell’idea è, probabilmente, corretta, e, in termini di documentazione sperimentale, una delle cose che uscivano dalla ricerca della struttura era che le parti funzionali importanti del ribosoma erano, proprio, costituite da RNA. Dunque, si poteva pensare al ribosoma come avente un nucleo fondamentale antico costituito da RNA, e poi, le proteine, che il ribosoma aveva prodotto, sono state aggiunte.

Certo, nella ricerca si cercava di mappare dove erano tutte le proteine. In retrospettiva, si scoprì che anche se avessimo avuto un modello di struttura, ad alta risoluzione, di quelle proteine e una posizione approssimativa, ciò non ci avrebbe detto come funzionava il ribosoma. Per avere una tale informazione, c’era bisogno di una visione dell’intera struttura. Si pensava che fosse quasi impossibile perché era molto più difficile rispetto qualsiasi ricerca risolta dalla cristallografia. Poi, nel 1980, in Germania, è avvenuta una svolta con Ada Yonath26 e Heinz-Günter Wittmann,27 che riportarono i primi cristalli reali di sotto unità dei ribosomi.28 , 29

All’epoca, un gruppo di ricercatori30 che stava lavorando con un organismo diverso, un termofilo di un livello di complessità più alto, scoperto nelle terme della penisola di Izu in Giappone, chiamato Thermus thermophilus, realizzò che i ribosomi di quell’organismo potevano cristallizzarsi, e ottennero cristalli delle piccole sub-unità così come dell’intero ribosoma. Ma nessuno di questi cristalli si diffrangeva31 molto bene.32

Sviluppo della conoscenza sui ribosomi: Ada Yonath ottiene cristalli a risoluzione sufficientemente alta da consentire di costruire un modello atomico

Per molto tempo, i ricercatori hanno tenuto duro. Una seconda svolta è arrivata quando, nel 1987, il gruppo di Ada Yonath ottiene cristalli della sub-unità grande ad una risoluzione sufficientemente alta, da consentire di costruire un modello atomico. Ma ciò significava trovare cristalli sufficientemente ben ordinati, cioè con tutte le molecole organizzate molto vicine nello stesso orientamento, in modo che, quando si fosse stabilita la loro media, non ci fosse molto sfocatura e si potesse ottenere una risoluzione elevata. Questa è stata una pietra miliare. Dopo di ciò, non c’è stato quasi nessun progresso verso la struttura e i ricercatori sul campo si sono sentiti frustrati.33

All’epoca, Venkatraman Ramakrishnan stava facendo dispersione di neutroni a Brookhaven e si era reso conto che la dispersione di neutroni non sarebbe mai stata una potente tecnica generale in biologia, quindi decise di cambiare il suo campo di ricerca, almeno cambiare tecniche. Allora, andò a fare un anno sabbatico a Cambridge per imparare la cristallografia. Dopo questi studi, egli ebbe l’idea che usando i sincrotroni e il fatto che si poteva sintonizzare le lunghezze d’onda dei raggi X nel sincrotrone attorno alle proprietà di certi atomi speciali, si poteva estrarre abbastanza segnale, anche, da qualcosa come un ribosoma, per raffigurarne un suo modello.34

Venkatraman Ramakrishnan, ancora ritenuto un fisico piuttosto che un biologo, non voleva lavorare sulla sub-unità grande perché sentiva che i biologi ricercatori non avrebbero visto di buon grado che lui avesse preso i cristalli di Ada Yonath e iniziato a lavorarci. Di conseguenza, egli iniziò a concentrarsi sulla sub-unità piccola, per la quale, al momento, non c’erano cristalli buoni, per quanto ne sapeva. Ma, poiché Ada Yonath era già da un po’ di tempo che conduceva ricerca, i biologi erano giunti alla conclusione che Ada Yonath non stava facendo progressi. Sentivano che lei aveva raggiunto un punto fermo e che altri avrebbero dovuto venire con nuove idee e se la ricerca poteva andare avanti.35

Anche se Venkatraman Ramakrishnan non voleva confrontarsi con lei, altri come Peter Moore e Tom Steitz36 pensavano che se lui non aveva intenzione di farlo, qualcun altro avrebbe dovuto farlo. Quindi, hanno preso quei cristalli come punto di partenza e hanno cercato di capire come metterli in fase, che è come ottenere le informazioni dai dati di diffrazione dei raggi X per essere in grado di spiegare o trovare una soluzione alla questione della struttura del ribosoma. In un tale contesto, Venkatraman Ramakrishnan pensava che, mentre si sarebbe sviluppata la gara tra Moore & Steitz e Yonath riguardo la sub-unità grande del ribosoma, lui avrebbe avuto la sotto-unità piccola per sé. La sub-unità piccola era un punto di partenza. Ramakrishnan pensava che se poteva farlo, era un buon momento per affrontare l’intero ribosoma.37

La gara si rivelò difficile perché, ad un certo punto, Ada Yonath, sentendo di perdere terreno nel gruppo di Yale, spostò la sua attenzione sulla sub-unità piccola. Dunque, invece di una gara di Moore & Steitz contro Yonath, Ramakrishnan si trovò a gareggiare con Ada Yonath per la struttura della sub-unità piccola. Alla fine si sono trovati con una struttura ad alta risoluzione più completa: sia il modello della struttura della sub-unità piccola, del gruppo della Yonath e del gruppo di Ramakrishnan, sia il modello della sub-unità grande del gruppo della Yale (Moore & Steitz), sono stati pubblicati a distanza di un mese l’uno dall’altro nel 2000. Ciò è stata una grande svolta.38

Poco tempo dopo, la coppia russa Marat Yusupov e Gulnara Yusupova39 si recò nel laboratorio di Harry Noller40 dove sono riusciti a riprodurre i cristalli di tutto il ribosoma. Naturalmente, non poterono spiegare o trovare una soluzione alla questione della struttura del ribosoma in una risoluzione atomica, in quel momento, perché quei cristalli ancora non erano abbastanza buoni. Ma poiché avevano la struttura di entrambe le sub-unità, sia il gruppo della Yale (Moore & Steitz) e sia i gruppi della Yonath e di Ramakrishnan, sono stati in grado di inserirle e arrivare a una struttura “molecolare” dell’intero ribosoma.41

Quindi la ricerca è andata avanti. È stato necessario ottenere strutture accurate di tutto il ribosoma eseguendo diverse attività: dal punto di partenza, nell’atto di accettare un tRNA, nell’atto di muoversi attraverso l’mRNA e nell’atto di terminazione, che significa riconoscere quando ha raggiunto un punto di arresto, cioè quando una proteina speciale si rende disponibile, ne riconosce la fine e taglia via questa proteina appena prodotta in modo che possa liberarsi dal ribosoma e attendere alle sue funzioni cellulari. Tutte queste fasi hanno richiesto molto tempo di ricerca. Ognuna era un progetto pluriennale, progetti che si sono sviluppati dal 2000 fino a pochi anni fa.42

Circa quattro anni fa è sopraggiunta una nuova tecnica: la microscopia elettronica a particelle singole.43 Questa è una tecnica per ottenere strutture tridimensionali semplicemente guardando particelle non orientate, particelle orientate casualmente, in microscopia elettronica. La tecnica era in circolazione già da parecchio tempo. Era stata usata per i virus negli anni ‘70, nel laboratorio dove Ramakrishnan lavorava con Tony Crowther44 e Aaron Klug,45 che era il direttore e che aveva, anche lui, ricevuto un premio Nobel.46

Si era riusciti a sviluppare questa tecnica, ma non era stata usata per particelle senza simmetria. I virus han- no, invece, molta simmetria e il problema del rapporto segnale / rumore è molto più facile per essi. Studiosi come Joachim Frank e Marin van Heel47 hanno sviluppato tecniche per utilizzare questo metodo, anche, con particelle prive di simmetria, come il ribosoma. Ma la risoluzione che potevano ottenere era piuttosto limitata.

Infatti, allora, questi ricercatori erano soprannominati, da alcuni altri studiosi, come i “blobologists” (biologi dei blob[efn-note]Il termine blob significa “massa priva di forma e di consistenza”, può essere riferito alla biologia per denominare una massa di materia organica arenato sulla riva di un oceano o altra superficie acquatica.[/efn_note]) perché in quel momento ciò che era visibile era una massa di materia organica. Non c’è modo di dedurre una struttura atomica da praticamente zero. Naturalmente, una volta colto un modello della struttura generale mediante la cristallografia, fu possibile inserire il modello della struttura atomica nei loro blob e affermare: “Questo blob è questa proteina e questo blob è questo pezzo di RNA”. Ma ciò non significava aver risolto la questione della struttura ad alta risoluzione. Una tale struttura è stata la costruzione di un modello da differenti angolature di conoscenza pregressa.

Sviluppo della conoscenza sui ribosomi: entrare nella struttura atomica del ribosoma usando microscopia elettronica senza cristalli

Infatti, un certo numero di conoscenza pregressa si era accumulata negli anni. Una di queste portò Richard Henderson48 a rendersi conto, già negli anni ‘90, che era possibile entrare nella struttura atomica semplicemente usando la microscopia elettronica senza cristalli. Egli si rese conto che il problema era:

a) che i microscopi al tempo non erano abbastanza efficienti, e

b) che i rilevatori non erano abbastanza efficaci ed, inoltre, troppo lenti.

Così egli trascorse molto tempo lavorando da solo e in collaborazione con altri laboratorie aziende commerciali per sviluppare microscopi migliori e rivelatori migliori.

Poi, c’erano i ricercatori che sviluppavano algoritmi più sofisticati, come gli algoritmi bayesiani, per l’apprendimento automatico. Gli algoritmi bayesiani sono estremamente utili per analizzare i dati molto “rumorosi” delle micrografie elettroniche. Infatti, se si guardava una foto delle micrografie elettroniche e si osservava che aspetto avesse un ribosoma, appariva molto “rumoroso”. È ancora un po’ incredibile, per molti esperti, che si possa ottenere una struttura atomica da qualcosa del genere, eppure si può. Tutte queste tecniche, sia hardware che software, hanno continuato a migliorare. E poi, alcuni anni fa, si è fatto un incredibile passo avanti.49

La scienza è importante per la salute di ciascuno di noi

Oggi, si possono ottenere strutture ad alta risoluzione del ribosoma senza cristalli, tecnica che ci procurò le prime strutture del ribosoma. Le nuove tecniche hanno aperto a tutti i tipi di possibilità non solo per il ribosoma ma per tutti i tipi di processi cellulari. Ora possiamo esaminare quantità molto piccole di un campione, campione che non ha nemmeno bisogno di essere puro in quanto potrebbe essere una miscela di stati (riguardanti la sua biochimica, composizione molecolare, evoluzione, sviluppo, genetica).

Catturando tutti questi stati, contemporaneamente, siamo in grado di visualizzare e ottenere strutture molecolari per tutte le dimensioni da un singolo campione. Per un biologo strutturale, questo è un sogno. Ai vecchi tempi si doveva capire, attentamente, come intrappolare uno stato particolare, assicurarsi che fosse stabile, purificarlo, cercando di cristallizzarlo e sperare che si cristallizzasse abbastanza bene. Ci sono voluti anni e anni, ma attualmente si possono intrappolare una serie di stati, possibilmente da un singolo esperimento o da qualche esperimento correlato.

Il ribosoma è piuttosto abbondante, ed è anche facile da spiegare, con questo metodo, perché ha un alto contrasto. Se si osservano i processi fondamentali nella cellula, quasi ognuno di essi viene eseguito da un dinamismo [meccanismo] complesso. Si guardi, ad esempio, alla replicazione del DNA, un “meccanismo” straordinario. Il complesso di DNA polimerasi50 appartiene a questo enorme e dinamico “meccanismo”.51

Dopo vari decenni, oggi, si sta sempre più perfezionando la conoscenza della cellula in frazioni sempre più piccole, cioè nei minimi particolari. Il vero progresso è che saremo sempre più in grado di guardare tutti questi meccanismi e grandi complessi molecolari e alla loro funzionalità cellulare.52 Informazioni sempre più dettagliate saranno sempre più importanti per scoprire e debellare malattie non ancora curabili e l’impatto in medicina sarà piuttosto profondo a lungo termine.53

Tornando al ribosoma, i due grandi momenti di scoperta furono l’identificazione (scoperta) del ribosoma stesso e la comprensione della sua funzionalità per formare una proteina specifica. Un macchinario da due milioni e mezzo di Dalton54 nei batteri e quasi il doppio di quella massa atomica negli organismi più complessi, un meccanismo da un milione di atomi che consuma continuamente energia per assolvere a questo processo. E lo fa in modo alquanto preciso.55

Ancora oggi, i migliori sintetizzatori proteici che abbiamo in laboratorio non hanno mai raggiunto la velocità e la precisione del ribosoma, una “macchina” straordinaria. Che il ribosoma avesse un ruolo importante nelle dinamiche cellulari è stata una grande intuizione risalente agli anni ‘50 del secolo scorso. Altro punto importante è stato identificare le strutture atomiche del ribosoma. Ciò è accaduto dal 2000 in poi. Oggi possiamo “vedere” modelli di questa “macchina” di lettura dell’informazione genetica e della produzione delle proteine in termini atomici. E questo permette di fare domande in termini di chimica. Come funziona questa macchina che chiamiamo ribosoma, in termini di meccanismi chimici? Ad alcuni ricercatori piace dire che l’ RNA ribosomiale è molto più vecchio del DNA ed è responsabile della funzionalità di quasi tutto ciò che accade nella cellula. Da questo punto di vista, il ribosoma è assolutamente fondamentale per comprendere come la vita sia diventata quella che è oggi, e gioca un ruolo fondamentale in biologia.56

In definitiva, questo breve accenno alla costruzione della conoscenza su ciò che denominiamo ribosoma dovrebbe essere sufficiente a farci intuire come funziona la costruzione di una conoscenza, di una scienza. La rilevanza per la vita e la salute umana e delle altre specie di un singolo costituente cellulare, mette in rilievo che la scienza è importante non solo per i governi e le industrie che se ne avvalgono ma, soprattutto, per il benessere di ciascuno di noi, per la società tutta, per la salute delle popolazioni. In definitiva, dobbiamo imparare a pensare alla scienza in un contesto di bio-socio-politica più ampio e confacente alle nostre esigenze.

- I ribosomi sono complessi macromolecolari, immersi nel citoplasma o ancorati al reticolo endoplasmatico ruvido o contenuti in altri organuli (mitocondri e cloroplasti), responsabili della sintesi proteica.

- Il terabyte è un’unità di misura dell’informazione o della quantità di dati, il termine deriva dalla unione del prefisso SI tera con byte ed ha per simbolo TB. Il prefisso tera deriva dai termini greci τέρας (mostro) e tetra a ricordare la quarta potenza di 1000. A causa dell’uso improprio dei prefissi binari, nel definire e usare il kilobyte, il valore del terabyte nella pratica comune ha potuto assumere i seguenti significati: 1 000 000 000 000 byte = 10004 = 1012 byte = 1 bilione di byte e 1 099 511 627 776 byte = 10244 = 240 byte = 1 tebibyte. Il tebibyte, che è uno standard definito dalla Commissione elettrotecnica internazionale (IEC), esprime 1 099 511 627 776 B senza nessuna incertezza e dovrebbe quindi essere utilizzato al posto del più diffuso terabyte per esprimere tale quantità. Rimane corretto usare il termine terabyte, nel significato di mille miliardi di byte, se si è interessati ad esprimere solo un ordine di grandezza e non una quantità precisa.

- Il Nobel per la chimica 2017 alla crio-microscopia elettronica. Premiati Jacques Dubochet, Joachim Frank e Richard Henderson, per il loro contributo allo sviluppo della crio-microscopia elettronica, una tecnica che permette di ricostruire la struttura tridimensionale delle molecole con dettaglio atomico e che negli ultimi anni ha avuto un impatto enorme negli studi di biologia e farmacologia. Uno sguardo assai ravvicinato alla struttura e al comportamento delle molecole biologiche è possibile da qualche anno grazie ai progressi della tecnica di crio-microscopia elettronica, fondamentali per la produzione di nuovi composti chimici, in particolare nell’industria farmaceutica. Questi progressi sono valsi a Jacques Dubochet, Joachim Frank e Richard Henderson il premio Nobel per la chimica di quest’anno. La microscopia elettronica è stata una delle tecniche più ingegnose e ricche di risultati scientifici di tutto il Novecento. Il principio di base è piuttosto semplice: superare i limiti d’ingrandimento della microscopia ottica sostituendo la radiazione luminosa con un fascio di elettroni, che secondo il principio della dualità onda-particella della meccanica quantistica, hanno una lunghezza d’onda decisamente inferiore rispetto a quella della luce. E in microscopia, la lunghezza d’onda della radiazione usata come “sonda” è proporzionale alle dimensioni che si possono osservare, o “risolvere” come si dice in gergo tecnico: nel caso degli elettroni, è possibile definire anche le posi- zioni di singoli atomi. Tutto ciò che occorre è un circuito elettronico progettato per interpretare la “risposta” del campione investito dal fascio di elettroni. Nonostante gli enormi vantaggi evidenti nei campi più disparati della ricerca, la microscopia elettronica, nelle sue prime realizzazioni, aveva un limite fondamentale: non poteva essere usata sui delicati campioni biologici. Sfruttando un fascio potente, necessario per ottenere immagini con una risoluzione elevata, si sarebbe incenerito il materiale biologico, mentre con un fascio meno potente le immagini diventano molto confuse, vanificando gli sforzi di osservazione delle strutture più piccole. Inoltre, la microscopia elettronica richiede condizioni di vuoto piuttosto spinto, in cui però le bio-molecole si degradano.

- L’apprendimento automatico (machine learning ), rappresenta un insieme di metodi sviluppati negli ultimi decenni in varie comunità scientifiche con diversi nomi come: statistica computazionale, riconoscimento di pattern, reti neurali artificiali, filtraggio adattivo, teoria dei sistemi dinamici, elaborazione delle immagini, data mining, algoritmi adattivi, ecc; che “fornisce ai computer l’abilità di apprendere senza essere stati esplicitamente programmati”. Nel campo dell’apprendimento automatico, una rete neurale artificiale (in inglese artificial neural network, abbreviato in ANN o anche come NN) è un modello matematico composto di “neuroni” artificiali, che si ispira a una rete neurale naturale.

- Una rete neurale è un insieme di neuroni biologici tra loro interconnessi. Nell’uso moderno si intende però di solito con rete neurale una rete di neuroni artificiali, che cerca di simulare il funzionamento dei neuroni all’interno di un sistema informatico. Può essere composta sia da programmi che da hardware dedicato. Spesso viene utilizzata in congiunzione alla logica fuzzy e funge da base per molti sistemi di intelligenza artificiale. Fondamenti biologici. In quasi tutti gli organismi viventi sono presenti complesse organizzazioni di cellule nervose, con compiti di riconoscimento delle configurazioni assunte dall’ambiente esterno, memorizzazione e reazione agli stimoli provenienti dallo stesso. Il cervello umano rappresenta probabilmente il più mirabile frutto dell’evoluzione per le sue capacità di elaborare informazioni. Al fine di compiere tali operazioni, le reti biologiche si servono di un numero imponente di semplici elementi computazionali (neuroni) fittamente interconnessi in modo da variare la loro configurazione in risposta agli stimoli esterni: in questo senso si può parlare di apprendimento ed i modelli artificiali cercano di catturare questo tratto distintivo della biologia. Tipicamente un neurone è costituito di 3 parti principali: il soma (corpo cellulare), l’assone (linea di uscita del neurone unica ma che si può diramare anche in migliaia di rami) e il dendrite (detto anche albero dendritico in quanto la sua estesa ramificazione ne ricorda la forma, il quale funge da linea di entrata del neurone che riceve segnali in ingresso da altri assoni tramite sinapsi). Il corpo cellulare fa una “somma (algebrica) pesata” (integrazione) dei segnali in ingresso. Se il risultato eccede un certo valore di soglia allora il neurone si attiva ed è prodotto un “potenziale di azione” che è mandato all’assone. Se il risultato non eccede il valore di soglia, il neurone rimane in uno stato di riposo. Una rete neurale artificiale riceve segnali esterni su uno strato di nodi (unità di elaborazione) d’ingresso, ciascuno dei quali è collegato con numerosi nodi interni, organizzati in più livelli. Ogni nodo elabora i segnali ricevuti e trasmette il risultato a nodi successivi.

- Venkatraman Ramakrishnan (Chidambaram, 1º aprile 1952) è un chimico e biologo indiano naturalizzato britannico, vincitore del premio Nobel per la chimica nel 2009 assieme a Thomas Arthur Steitz e Ada Yonath per i suoi studi sulla struttura e sulla funzione dei ribosomi. Dal 1999 al 2015 ha lavorato a Cambridge, presso il laboratorio di biologia molecolare del Medical Research Council. È stato presidente della Royal Society di Londra dal 2015 al 2020. Dal 1977 a oggi Ramakrishnan ha pubblicato oltre 95 lavori di ricerca nelle più importanti riviste scientifiche internazionali. Fra i suoi principali lavori di questo periodo hanno notevole rilevanza quelli sulla struttura dell’Istone e della cromatina. Nel 2000, il laboratorio da lui diretto ha determinato la struttura tridimensionale della sub-unità 30S dei ribosomi e dei complessi formati con substrati e antibiotici. I risultati di queste ricerche sono riportati in tre articoli nei numeri del 26 agosto e del 21 settembre 2000 della rivista Nature. A questo lavoro sono seguiti studi sulla sintesi proteica e sulla struttura atomica dell’intero ribosoma in complessi formati con il suo tRNA e mRNA.

- Ribosoma. In biologia, ciascuna delle particelle ricche di acido ribonucleico presenti in gran numero nel citoplasma cellulare; i ribosomi sono i siti ove avviene il processo di traduzione del messaggio genetico portato dall’RNA messaggero, cioè la sintesi proteica. I ribosomi sono complessi macromolecolari, immersi nel citoplasma o an- corati al reticolo endoplasmatico ruvido o contenuti in altri organuli (mitocondri e cloroplasti), responsabili della sintesi proteica. La loro funzione è quella di leggere le informazioni contenute nella catena di RNA messaggero (m-RNA). Furono messi in evidenza nel 1953 al microscopio elettronico dal biologo rumeno George Emil Palade, scoperta che gli valse il Premio Nobel. Il termine ribosoma fu invece proposto nel 1958 da Richard B. Roberts. I ribosomi sono responsabili della sintesi delle proteine.

- Come abbiamo visto la sintesi delle proteine è guidata dall’informazione portata da molecole di mRNA. Per mantenere il corretto quadro di lettura e per assicurare accuratezza (circa 1 errore ogni 10.000 aminoacidi), la sintesi proteica viene eseguita sul ribosoma, una complessa macchina catalitica composta da più di 50 proteine diverse, le proteine ribosomiali) e da alcune molecole di RNA, gli RNA ribosomiali (rRNA). Una tipica cellula eucariotica contiene milioni di ribosomi nel citoplasma…. I ribosomi eucariotici e procariotici hanno strutture e funzioni molto simili. Entrambi sono composti da una sub-unità maggiore e una minore che si adattano formando un ribosoma completo… la sub-unità minore fornisce una struttura sulla quale i tRNA possono essere adattati accuratamente ai codoni dell’mRNA, mentre la sub-unità maggiore catalizza la formazione di legami peptidici che uniscono assieme gli aminoacidi in una catena polipeptidica. Quando non stanno sintetizzando attivamente proteine, le due sub-unità del ribosoma sono separate per poi riunirsi per la sintesi di una nuova proteina su una molecola di mRNA. Viene quindi tirato attraverso il ribosoma, quando i suoi codoni incontrano il sito attivo del ribosoma, la sequenza nucleotidica dell’RNA viene tradotta in una sequenza di aminoacidi usando i tRNA come adattatori per aggiungere ciascun aminoacido nella sequenza corretta all’estremità della catena polipeptidica in crescita. Quando viene incontrato un codone di stop, il ribosoma rilascia la proteina finita e le sue due sub-unità si separano di nuovo. Queste sub-unità possono poi essere usate per iniziare la sintesi di un’alta proteina su un’altra molecola di mRNA. Come fa un ribosoma a orchestrare i molti movimenti coordinati necessari per una traduzione efficiente? Un ribosoma contiene quattro siti di legame per molecole di RNA, uno è per l’mRNA e tre ( chiamati sito A, sito P e sito E)sono per tRNA . Una molecola di tRNA è tenuta con forza nei siti A e P soltanto se l’anticodone forma coppie di basi con un codone complementare sulla molecola di mRNA che è attaccata al ribosoma. I siti A e P sono abbastanza vicini da forzare le loro due molecole di tRNA a formare coppie di basi con codoni adiacenti sulla molecola di mRNA. Questa caratteristica del ribosoma mantiene il corretto quadro di lettura sull’mRNA. Una volta che la sintesi proteica è iniziata ciascun nuovo aminoacido viene aggiunto alla catena in allungamento in un ciclo di reazioni che contiene tre passaggi principali. Fonte: “BIOLOGIA MOLECOLARE DELLA CELLULA” quarta edizione Zanichelli.

- Prima dello sviluppo della cristallografia per diffrazione dei raggi X (che venne ad opera di Max von Laue nel 1912), lo studio dei cristalli era basato sulla geometria dei cristalli. La cristallografia a raggi X è una tecnica della cristallografia in cui l’immagine, prodotta dalla diffrazione dei raggi X attraverso lo spazio del reticolo atomico in un cristallo, viene registrata e quindi analizzata per rivelare la natura del reticolo. In genere, questo porta a determinare il materiale e la struttura molecolare di una sostanza. Lo spazio nel reticolo cristallino può essere determinato con la legge di Bragg. Gli elettroni che circondano gli atomi, piuttosto che i nuclei degli atomi stessi, sono le particelle che interagiscono fisicamente con i fotoni dei raggi X. Nella cristallografia a raggi un fascio di raggi X colpisce il cristallo stesso e viene quindi diffrato in direzioni specifiche. A seconda degli angoli e dell’intensità di questi raggi diffratti un cristallografo può produrre un’immagine tridimensionale della densità di elettroni nel cristallo. Da questa è possibile ricavare la posizione media degli atomi, così come i loro legami chimici ed altre informazioni. Dato che numerose molecole organiche, inorganiche e biologiche formano cristalli (tra questi, ad esempio, i sali, i metalli ed i semiconduttori) la cristallografia è utilizzata in numerose applicazioni scientifiche in campi differenti. Nel primo decennio di utilizzo questo metodo ha permesso di determinare la grandezza degli atomi, la lunghezza ed il tipo dei legami chimici e lo studio su scala atomica delle differenze tra i vari materiali in particolare metalli e leghe. Questa tecnica ha anche permesso di studiare la struttura ed il funzionamento di molte molecole biologiche, inclusi vitamine, proteine e acidi nucleici come quelli presenti nel DNA. La cristallografia a raggi X è ancora il metodo principalmente utilizzato per la caratterizzazione atomica dei nuovi materiali e per differenziare materiali che appaiono simili ad altre tecniche di indagine. La struttura cristallina ottenuta dai raggi X può spiegare la presenza di inusuali proprietà elastiche ed elettroniche in un materiale. In una misura di diffrazione a raggi X un cristallo è montato su un goniometro e gradualmente ruotato mentre viene bombardato con raggi X che producono una figura di diffrazione di punti regolarmente spaziati. Se il cristallo è troppo piccolo o non omogeneo questo risulta in una bassa risoluzione dell’immagine. La cristallografia a raggi X è uno dei metodi per determinare le strutture atomiche insieme allo scattering di elettroni o neutroni. Se non si possono ottenere cristalli di grandezza sufficiente è possibile applicare altre tecniche a raggi X per ottenere informazioni meno dettagliate sul cristallo come la diffrazione di raggi X su fibra, la diffrazione da polveri e la tecnica SAXS (small-angle X-ray scattering). Se il materiale da esaminare è disponibile solo in forma di polveri nanocristalline o soffre di bassa cristallinità possono essere applicati i metodi della cristallografia elettronica per la determinazione della struttura atomica.

- John Cowdery Kendrew biochimico e cristallografo, vincitore, insieme a Max Perutz (biologo e cristallografo), del premio Nobel per la chimica nel 1962, per gli studi

effettuati sulle strutture delle proteine globulari quali emoglobina e mioglobina tramite l’utilizzo di tecniche di diffrazione dei raggi X. - Il Laboratorio di Biologia Molecolare MRC è uno dei principali istituti di ricerca a livello mondiale. I suoi scienziati lavorano per progredire nella comprensione dei processi biologici a livello molecolare, fornendo la necessaria conoscenza per risolvere problemi chiave della salute umana.

- La cristallizzazione delle proteine è il processo di formazione di cristalli di proteine. Mentre alcuni cristalli proteici sono stati osservati in natura, la cristallizzazione delle proteine è utilizzato prevalentemente per scopi scientifici o industriali, in particolare per lo studio con la cristallografia a raggi X. Come molti altri tipi di molecole, le proteine possono essere indotte a formare cristalli quando la soluzione in cui sono disciolte diventa sovra-satura. In queste condizioni, singole molecole proteiche possono impacchettarsi secondo una disposizione geometricamente regolare, che si ripete nelle tre dimensioni spaziali, tenute insieme da interazioni non covalenti. Questi cristalli possono essere usati in biologia strutturale per studiare la struttura molecolare della proteina, o per diversi scopi industriali e biotecnologici. Le proteine sono macromolecole biologiche e funzionano in un ambiente acquoso, pertanto la cristallizzazione delle proteine viene prevalentemente effettuata in soluzione acquosa. La cristallizzazione delle proteine è tradizionalmente considerata difficile a causa delle restrizioni dell’ambiente acquoso, difficoltà di ottenere campioni di proteine di alta qualità, nonché sensibilità dei campioni proteici alla temperatura, pH, forza ionica, e altri fattori. Le proteine variano notevolmente nelle loro caratteristiche chimico-fisiche e così la cristallizzazione di una particolare proteina è difficilmente prevedibile. La determinazione delle appropriate condizioni di cristallizzazione per una determinata proteina spesso richiede la verifica empirica di molte condizioni prima di trovare le corrette condizione di cristallizzazione. In natura, questo fenomeno è osservabile nei calamari lucciola diffusi nel mare del Giappone. In questi molluschi infatti, alcune cellule concentrano cristalli di proteine al loro interno generando il fenomeno di bioluminescenza.

- Betamax, sviluppato dalla Sony, fu il primo sistema di videoregistrazione magnetica destinato al mercato domestico. Introdotto sul mercato alcuni anni prima del VHS, che da molti era considerato “tecnicamente inferiore” rispetto al prodotto Sony, ma che grazie a una serie di fattori fu l’unico a diffondersi con successo. (Wiki)

- VAX è un’architettura hardware per sistemi a 32 bit sviluppata da DEC verso la metà degli anni settanta. l VAX veniva percepito come l’architettura CISC più raffinata, per via della vasta gamma di modi di indirizzamento disponibili e per le istruzioni, che includevano persino operazioni complesse, quali l’inserimento e la cancellazione nelle code e il calcolo polinomiale. (Wiki).

- Un dataset (o data set) è una collezione di dati. Più comunemente un dataset costituisce un insieme di dati strutturati in forma relazionale, cioè corrisponde al contenuto di una singola tabella di database, oppure ad una singola matrice di dati statistici, in cui ogni colonna della tabella rappresenta una particolare variabile, e ogni riga corrisponde ad un determinato membro del dataset in questione. La dimensione del dataset è data dal numero dei membri presenti, che formano le righe, e dal numero delle variabili di cui si compone, che formano le colonne. Il termine dataset può essere usato anche più genericamente, per indicare i dati in un insieme di tabelle strettamente connesse, relative ad un particolare esperimento o evento.

- Il World Wide Web (letteralmente “rete di grandezza mondiale”), abbreviato Web, sigla WWW o W3, è uno dei principali servizi di Internet, che permette di navigare e usufruire di un insieme molto vasto di contenuti amatoriali e professionali (multimediali e non) collegati tra loro attraverso legami (link), e di ulteriori servizi accessibili a tutti o ad una parte selezionata degli utenti di Internet. Questa facile reperibilità di informazioni è resa possibile, oltre che dai protocolli di rete, anche dalla presenza, diffusione, facilità d’uso ed efficienza dei motori di ricerca e dei web browser in un modello di architettura di rete definito client-server.

- Il rumore in psicologia e semiotica, è un disturbo causato dall’eccesso di informazioni, tale che anche l’elemento potenzialmente utile non viene riconosciuto, nemmeno individuato, o individuato con difficoltà. In elettronica il rumore è l’insieme di segnali, in tensione o corrente elettrica, imprevisti e indesiderati che si sovrappongono al segnale utile, trasmesso o da elaborare, tipicamente presente sul canale di comunicazione tra due o più utenti (o apparati elettronici) e sui dispositivi di ricezione/elaborazione. Il rumore provoca una perdita d’informazione o un’alterazione del messaggio trasmesso.

- Il Go è un gioco da tavolo strategico per due giocatori. Ebbe origine in Cina, dove è praticato da almeno 2500 anni; è molto popolare in Asia orientale, ma si è diffuso nel resto del mondo negli anni recenti. È un gioco molto complesso strategicamente malgrado le sue regole semplici; un proverbio coreano dice che nessuna partita di Go è mai stata giocata due volte, il che è verosimile se si pensa che ci sono 2,08 × 10170 diverse posizioni possibili su un goban 19×19. Il Go è giocato da due giocatori che collocano alternativamente pedine nere e bianche sulle intersezioni vuote di una “scacchiera” (detta goban) dotata di una griglia 19 × 19. Lo scopo del gioco è il controllo di una zona del goban maggiore di quella controllata dall’avversario; a questo scopo i giocatori cercano di disporre le proprie pietre in modo che non possano essere catturate, ritagliandosi allo stesso tempo dei territori che l’avversario non possa invadere senza essere catturato. È infatti possibile catturare una pietra o un gruppo di pietre avversarie circondandole completamente con pietre proprie, in modo che non abbiano intersezioni libere adiacenti. Disporre le pietre vicine tra loro permette di rafforzarle a vicenda ed evitarne la cattura; d’altro canto, disporle distanti tra loro permette di creare influenza su tutto il goban. Parte della difficoltà strategica del gioco consiste nel trovare un equilibrio tra queste necessità opposte. I giocatori cercano di soddisfare contemporaneamente le esigenze offensive e difensive e scelgono tra le priorità tattiche e i loro piani strategici. Il gioco termina quando i giocatori passano consecutivamente, indicando che nessuno dei due può incrementare il proprio territorio o diminuire quello dell’avversario.

- La discesa dei prezzi per l’hardware e lo sviluppo di GPU per uso personale negli ultimi anni hanno contribuito allo sviluppo del concetto di apprendimento profondo, che consiste nello sviluppare livelli nascosti multipli nelle reti neurali artificiali. Questo approccio tenta di modellizzare il modo in cui il cervello umano processa luce e suoni e li interpreta in vista e udito. Alcune delle applicazioni più affermate dell’apprendimento profondo sono la visione artificiale e il riconoscimento vocale.

- Francis Harry Compton Crick, neuroscienziato, biofisico, biologo molecolare, premio Nobel per la medicina nel 1962 insieme a James Watson. Il 7 marzo del 1953 Watson e Crick realizzano il primo modello di DNA. Esso prevedeva una struttura a doppia elica con catene antiparallele e spiegava anche la complementarità delle basi. Ogni singolo giro di elica era costituito da 10 nucleotidi che quindi potevano trovare spazio su un’intera spira di 360 gradi: l’angolo compreso tra ogni zucchero e il successivo era dunque di 36 gradi. Le basi formavano tra loro legami a idrogeno unendosi alle estremità come tessere del domino. Rompendo i legami a idrogeno la struttura poteva esser aperta come una cerniera e ciò garantiva la duplicazione dei codici.

- Max Ludwig Henning Delbrück biofisico tedesco, premio Nobel per la medicina nel 1969, insieme a Salvador Luria e Alfred Hershey, per la scoperta della replicazione dei virus e della loro struttura genica.

- Donald Max Engelman, professore di biochimica alla Yale University e membro della National Academy of Sciences. È impegnato nella ricerca dell’utilizzo dei peptidi per aiutare alla distruzione dei tumori.

- Peter B. Moore Professore di Biofisica e biochimica alla Yale University. Ha dedicato la sua intere carriera alla comprensione della struttura, la funzione e il meccanismo del ribosoma.

- Lo scattering di neutroni è un particolare processo di scattering in cui un fascio di neutroni interagisce con la materia. L’analisi dei neutroni dopo l’interazione permette di ricavare informazioni sul materiale. In particolare, lo scattering elastico di neutroni è utilizzato in cristallografia per la determinazione della struttura cristallina; inoltre, nella fisica dello stato solido, questa tecnica è utilizzata per l’analisi delle proprietà dei fononi e delle proprietà magnetiche. In fisica la diffusione ottica (o dispersione), conosciuta come scattering, si riferisce a un’ampia classe di fenomeni di interazione radiazione-materia in cui onde o particelle vengono deflesse (ovvero cambiano traiettoria) a causa della collisione con altre particelle o onde (dal punto di vista quantistico). La deflessione avviene in maniera disordinata e in buona misura casuale (il significato letterale di scattering è “sparpagliamento”) e per questo la diffusione si distingue dalla riflessione e dalla rifrazione, che invece cambiano le traiettorie in maniera regolare e determinata. Sono considerati processi di scattering solo le interazioni elastiche o quasi elastiche, che cioè non comportino rilevanti cessioni o guadagni di energia.

- James Dewey Watson: biologo che scoprì la struttura della molecola del DNA insieme a Francis Crick, Maurice Wilkins e Rosalind Franklin. Assieme a Crick e Wilkins ricevette anche il Premio Nobel per la medicina nel 1962, per le scoperte sulla struttura molecolare degli acidi nucleici e il suo significato nel meccanismo di trasferimento dell’informazione negli organismi vivente.

- Ada E. Yonath, chimica e cristallografa, vincitrice del premio Nobel per la chimica nel 2009 assieme a Thomas Arthur Steitz e a Venkatraman Ramakrishnan per i suoi studi sulla struttura e sulla funzione dei ribosomi. Dirige lo Helen and Milton A. Kimmelman Center for Biomolecular Structure and Assembly del Weizmann Institute of Science. Nel 2009 è diventata la prima donna israeliana a vincere un premio Nobel, la prima donna del Medio Oriente a vincere un premio Nobel, nonché la prima donna a vincere un premio Nobel per la chimica in 45 anni.

- Biochimico conosciuto per le sue ricerche sui ribosomi.

- Mariusz Jaskolski , Zbigniew Dauter and Alexander Wlodawer. A brief history of macromolecular crystallography, illustrated by a family tree and its Nobel fruits. In “the FEBS journal” 281, pp. 3985-4009, 2014

- Il ribosoma ha due sub-unità (una più grande e l’atra più piccola) la cui funzione è quella di leggere le informazioni contenute nella catena di RNA messaggero (m-RNA) per eseguire la sintesi delle proteine. Si può immaginare questa funzione, rappresentandocela nella mente, come due sub-unità che funzionano come una “chiave a cricchetto” per leggere attraverso il “nastro di telescrivente” del RNA messaggero e si muove lungo questo nastro mentre producono una proteina. Nella ricerca d laboratorio si era riusciti a produrre cristalli della più grande delle due sub-unità, ma non erano della qualità che potevano renderci un modello riuscito della struttura atomica, anche se la tecnologia era già in giro.

- Yusupov MM (Institute of Protein Research, Academy of Sciences of the USSR, Moscow), Garber MB, Vasiliev VD, Spirin AS. Thermus thermophilus ribosomes for crystallographic studies. In “Biochimie”, Jul-Aug 73 (7-8): 887-97, 1991.

- In fisica la diffrazione è un fenomeno associato alla deviazione della traiettoria di propagazione delle onde (come anche la riflessione, la rifrazione, la diffusione ol’interferenza) quando queste incontrano un ostacolo sul loro cammino. È tipica di ogni genere di onda, come il suono, le onde sulla superficie dell’acqua o le onde elettromagnetiche come la luce o le onde radio; la diffrazione si verifica anche nelle particolari situazioni in cui la materia mostra proprietà ondulatorie, in accordo con la dualità onda-particella. Gli effetti di diffrazione sono rilevanti quando la lunghezza d’onda è comparabile con la dimensione dell’ostacolo. In particolare per la luce visibile (lunghezza d’onda attorno a 0,5 µm) si hanno fenomeni di diffrazione quando essa interagisce con oggetti di dimensione sub-millimetrica.

- Soul of a Molecular Machine. A Conversation with Venki Ramakrishnan. 5.1.17 https://www.edge.org/conversation/venki_ramakrishnan-soul-of-a-molecular-machine

- Mariusz Jaskolski , Zbigniew Dauter and Alexander Wlodawer. A brief history of macromolecular crystallography, illustrated by a family tree and its Nobel fruits. In “the FEBS journal” 281, pp. 3985-4009, 2014.

- Ibidem

- Ibidem

- Thomas Arthur Steitz biochimico, vincitore del premio Nobel per la chimica nel 2009 assieme a Ada Yonath e a Venkatraman Ramakrishnan per i suoi studi sulla struttura e sulla funzione dei ribosomi.

- Edge. Soul of a Molecular Machine. A Conversation with Venki Ramakrishnan. 5.1.17 https://www.edge.org/conversation/venki_ramakrishnan-soul-of-a-molecular-machine

- Mariusz Jaskolski , Zbigniew Dauter and Alexander Wlodawer. A brief history of macromolecular crystallography, illustrated by a family tree and its Nobel fruits. In “the FEBS journal” 281, pp. 3985-4009, 2014.

- Gulnara Yusupova, Marat Yusupov. Crystal structure of eukaryotic ribosome and its complexes with inhibitors. Philosophical Transactions of the Royal Society Biological Sciences. Published 30 January 2017.

- Harry F. Noller, biochimico, dal 1992 direttore del Center for the Molecular Biology of RNA. Ci ha fornito contributi significativi per la nostra comprensione del ribosoma.

- Edge. Soul of a Molecular Machine. A Conversation with Venki Ramakrishnan. 5.1.17 https://www.edge.org/conversation/venki_ramakrishnan-soul-of-a-molecular-machine

- Mariusz Jaskolski et al. op. cit. 2014.

- Liu, X., Wang, H. Single Particle Electron Microscopy Reconstruction of the Exosome Complex Using the Random Conical Tilt Method. Molecular Biophysics and Biochemistry, Yale University, 2011.

- Tony Crowther. Matematico ricercatore esperto nell’assemblaggio di strutture macromolecolari.

- Aaron Klug: chimico biofisico, premio Nobel per la chimica nel 1982 “per il suo sviluppo della microscopia elettronica cristallografica e per aver chiarito la struttura dei complessi biologicamente importanti acidi nucleici-proteine”.

- Soul of a Molecular Machine. A Conversation with Venki Ramakrishnan. Op. cit. 2017.

- Joachim Frank, Richard Henderson & Marin van Heel sono riconosciuti per i loro contributi agli sviluppi che hanno trasformato gli studi strutturali delle molecole e dei complessi biologici.

- Joachim Frank, Richard Henderson & Marin van Heel sono riconosciuti per i loro contributi agli sviluppi che stanno a trasformare gli studi strutturali delle molecole e dei complessi biologici.

- Mariusz Jaskolski et al. op. cit. 2014.

- Le DNA polimerasi (DNA-dipendente) sono enzimi appartenenti alla categoria delle transferasi, che catalizzano la seguente reazione: deossinucleoside trifosfato + DNAn ⇄ difosfato + DNAn+1. Questi enzimi sono in grado di sintetizzare un filamento di DNA utilizzando come stampo (più conosciuto con il termine inglese “template”) un altro filamento di DNA e generando quindi un filamento complementare al primo nel processo di replicazione. Tutte le DNA polimerasi conosciute sintetizzano il nuovo filamento in direzione 5’- 3’ aggiungendo deossiribonucleotidi (dNTP) al gruppo 3’-OH del deossiribosio del nucleotide precedente. Nessuna DNA-polimerasi è in grado di iniziare la sintesi di un filamento “da zero” (ex novo). Per questa ragione le DNA-polimerasi necessitano di un oligonucleotide (in inglese “primers”) complementare al filamento templato. Questo primer è costituito da poche decine di nucleotidi e funge da innesco della reazione di amplificazione perché fornisce un gruppo idrossilico (-OH) in posizione 3’ a cui la DNA polimerasi legherà il primo nucleotide del filamento neosintetizzato. Tali inneschi possono essere sia di DNA sia di RNA. Durante la replicazione in vivo tali inneschi di RNA sono forniti da una speciale RNA polimerasi detta primasi. Questi inneschi verranno poi eliminati grazie ad alcuni tipi particolari di RNAsi, enzimi capaci di degradare l’RNA. Sarà poi compito dell’enzima DNA ligasi legare l’estremità 3’ del nuovo tratto sintetizzato con l’estremità 5’ del tratto di DNA precedente.

- Mariusz Jaskolski et al. op. cit. 2014.

- Edge. Soul of a Molecular Machine. A Conversation with Venki Ramakrishnan. Op. cit. 2017.

- Ibidem

- L’unità di massa atomica unificata (u) detta anche Dalton (Da) è un’unità di misura di massa che non fa parte del Sistema Internazionale di unità di misura, ma è da esso riconosciuta in virtù del largo impiego che ne viene fatto, specialmente in chimica, biochimica e biologia molecolare. Viene utilizzata frequentemente per la massa delle particelle elementari, di singoli atomi (massa atomica), molecole (massa molecolare), ioni, radicali. Questa unità è particolarmente diffusa anche perché sperimentalmente è più immediato confrontare masse di atomi e molecole, piuttosto che misurarne la loro massa, specialmente quando si utilizza uno spettrometro di massa.

- Mariusz Jaskolski et op. cit. 2014.

- Ibidem