BIO – Medicina Costruzione Sociale nella Post-Modernità – Educational Papers • Anno XII • Numero 46 • Giugno 2023

Per fare il punto … una presuntuosa introduzione all’informatica

La decostruzione che in quest’argomentazione affrontiamo è quella relativa alla nozione di cervello dominante oggi nella cultura convenzionale occidentale. Il punto di quest’esposizione, certamente, non è quello di mettere in discussione la definizione del cervello come l’organo principale del sistema nervoso centrale presente in tutti i vertebrati e nella maggior parte degli invertebrati. Non è nemmeno mettere in discussione l’idea riguardo la sua funzione che, insieme al sistema endocrino, sarebbe quella della regolazione delle funzioni vitali e di sede delle regolazioni omeostatiche e delle funzioni cerebrali superiori. Ciò che mi interessa decostruire in questa sede è, fondamentalmente, l’interpretazione delle neuroscienze riguardo le sue funzioni cognitive.

Per meglio inquadrare la discussione e rendere immediatamente esplicito il suo movente, utilizzerò il pensiero di Robert Epstein in materia, sintetizzato nel suo saggio The empty brain. [1] La sua posizione riguardo come interpretare il cervello nella contemporaneità è chiara ed eloquente. Non importa quanto ci provino, neuroscienziati e psicologi cognitivi non troveranno mai una copia della Quinta sinfonia di Beethoven nel cervello di nessuno, così come non si troveranno mai né copie di parole, di immagini, né di nessun altro tipo di stimolo ambientale. Stando a Epstein, il cervello umano non risulterebbe propriamente vuoto, ovviamente, e tuttavia non conterrebbe la maggior parte delle cose che il pensiero comune delle popolazioni delle nostre società considera che contenga. Al suo parere non conterrebbe nemmeno cose semplici come i cosiddetti “ricordi”. [2]

Il nostro pensiero obsoleto sul cervello avrebbe, per l’appunto, profonde radici storiche, ma, nell’opinione di Epstein [3], l’invenzione dei computer negli anni ’40 avrebbe reso la nostra nozione sul cervello particolarmente confusa. In effetti, da più di mezzo secolo psicologi, linguisti, neuroscienziati e altri esperti del comportamento umano affermano che il cervello umano funzioni come un computer. Per realizzare quanto sia vacua quest’idea, Epstein [4] ci invita a considerare il cervello dei neonati. Attraverso quest’esercizio potremmo ricordare che grazie all’evoluzione, i neonati umani, come i neonati di tutte le altre specie di mammiferi, entrerebbero nel mondo preparati a interagire con esso in modo efficace. La vista di un bambino sarebbe sfocata, ma presterebbe particolare attenzione ai volti e sarebbe rapidamente in grado di identificare quello della madre. Preferirebbe il suono del linguaggio vocale ai suoni che non corrispondono ad una vocalizzazione del linguaggio e potrebbe distinguere un suono vocale di base da un altro. Valutando con la nostra logica inferenziale queste pochissime e semplici considerazioni possiamo concludere che noi umani ci siamo evoluti, senza dubbio, per creare connessioni sociali.

Possiamo altresì aggiungere che un neonato sano sarebbe dotato di più di una dozzina di riflessi, cioè reazioni già pronte a determinati stimoli importanti per la sua sopravvivenza. Infatti, gira la testa in direzione di qualcosa che gli sfiora la guancia e succhia tutto ciò che entra nella sua bocca. Trattiene il respiro quando è immerso nell’acqua. Afferra le cose poste nelle sue mani così fortemente che può quasi sostenere il proprio peso. Forse l’aspetto più importante sarebbe che i neonati sono dotati di potenti meccanismi di apprendimento che consentono loro di cambiare rapidamente in modo da poter interagire in maniera sempre più efficace con il loro mondo, anche se quel mondo sia diverso da quello che avrebbero affrontato i loro lontani antenati. In breve, prendendo in considerazione il paradigma di interpretazione del cervello dei neonati sintetizzato da Epstein si potrebbe postulare che iniziamo soltanto con sensi, riflessi e meccanismi di apprendimento. E sarebbe parecchio, se si pensa. Se ci mancasse una di queste capacità alla nascita, probabilmente avremmo problemi a sopravvivere. Questa narrativa dei luoghi comuni circa il cervello umano non è certamente il motivo di quest’argomentazione.

Ciò che ci interessa per primo in questo breve e semplice tentativo di decostruzione della metafora interpretativa del cervello in circolazione nel pensiero comune è proprio ciò con cui, stando a Epstein e altri ricercatori [5], noi umani non saremmo nati: informazioni, dati, regole, software, conoscenza, lessici, rappresentazioni, algoritmi, programmi, modelli, memorie, immagini, processori, subroutine, codificatori, decodificatori, simboli o buffer, tutti elementi di progettazione che consentono ai computer digitali di comportarsi in modo che rammentino tratti che attribuiamo comunemente all’intelligenza umana. Per Epstein e tanti altri, non solo non siamo nati con questi elementi ma non li sviluppiamo nemmeno. E in quanto umani mai li svilupperemo [6]. Dalla loro prospettiva e contrariamente al pensiero comune noi umani non archiviamo le parole o le regole che ci dicono come manipolarle. Non creiamo rappresentazioni di stimoli visivi, né le memorizziamo in un buffer di memoria a breve termine e poi trasferiamo la rappresentazione in un dispositivo di memoria a lungo termine. Non recuperiamo informazioni o immagini o parole dai registri della memoria. I nostri cervelli non espleterebbero nessuna di queste funzioni metaforiche. I computer compiono tutte queste funzioni, ma gli organismi viventi no.[7]

I computer, letteralmente, elaborano informazioni: numeri, lettere, parole, formule, immagini. Le informazioni devono prima essere codificate in un formato binario che i computer possono utilizzare, il che significa modelli di zero o uno (“bit”) organizzati in piccoli blocchi (“byte”). Sul mio computer, ogni byte contiene 8 bit e un certo schema di quei bit sta per la lettera c, un altro per la lettera a, un altro per la lettera n e ancora un altro per la lettera e. Fianco a fianco, quei quattro byte formano la parola cane. Una singola immagine, diciamo, la fotografia della mia gatta Luna sul mio desktop, è rappresentata da uno schema molto specifico di un milione di questi byte (“un megabyte”), circondato da alcuni caratteri speciali che dicono al computer di aspettarsi un’immagine, non una parola. Ormai tutti noi siamo istruiti in materia. I computer, letteralmente, spostano questi schemi da un posto all’altro in diverse aree di archiviazioni fisiche incise nei componenti elettronici. A volte copiano anche gli schemi, a volte li trasformano in vari modi, in particolar modo quando correggiamo errori in un manoscritto o quando ritocchiamo una fotografia. Anche le regole che i computer seguono per spostare, copiare e operare su questi insiemi di dati sono memorizzate all’interno del computer. Unitamente, una serie di regole è chiamato “programma” o “algoritmo”. Un gruppo di algoritmi che lavorano congiuntamente per aiutarci a fare qualcosa (come acquistare prodotti o trovare un appuntamento online) è chiamato “applicativo”, ciò che la maggior parte delle persone ora chiama “app”.

Scusateci per questa presuntuosa introduzione all’informatica ma, per fare il punto riguardo all’obsolescenza della metafora del cervello come computer, vorremmo essere chiari: i computer operano per davvero su rappresentazioni simboliche del mondo. Conservano e recuperano per davvero. Elaborano per davvero. Hanno per davvero memorie fisiche. Sono effettivamente guidati in tutto ciò che fanno, nessuna operazione esclusa, da algoritmi. Noi esseri umani, d’altra parte, come sottolineano Epstein, Roberts e Beber [8], non lo facciamo, non l’abbiamo mai fatto e non lo faremo mai. Certamente, quest’interpretazione, fondata nella nostra esperienza fenomenica e nella nostra conoscenza teoretica della questione, è talmente condivisa che viene spontaneo da chiedersi come sia possibile che, data questa realtà, ci siano così tanti studiosi che parlano della nostra vita mentale come se fossimo dei computer.

Le metafore della nostra civiltà per descrivere il cervello e spiegare l’intelligenza umana

Ma ciò che accade oggi è qualcosa che sempre sarebbe accaduto. Tutto considerato, la metafora con la sua immagine di forte carica espressiva e la sua comprensione di un dominio concettuale nei termini di un altro è una figura abbastanza studiata nella linguistica cognitiva. A questo proposito, George Lakoff [9] ci ha suggerito il suo paradigma delle centralità della metafora nella società e nel pensiero umano nonché per descrizioni originali del processo scientifico. In effetti, stando a lui, lo sviluppo del pensiero sarebbe possibile perché esiste un processo cognoscitivo volto allo sviluppo di metafore migliori. Accettando questa premessa della linguistica cognitiva possiamo avanzare nella nostra decostruzione riepilogando i contesti storici con le loro rispettive metafore inerenti al cosiddetto cervello.

Nel suo libro In Our Own Image (2015) , l’esperto di intelligenza artificiale George [10] descrive sei diverse metafore che la nostra civiltà avrebbe utilizzato negli ultimi 2000 anni per cercare di spiegare l’intelligenza umana. Nella prima, conservata sostanzialmente nella Bibbia, noi, umani, eravamo formati da argilla o terra, che un dio intelligente avrebbe poi infuso con il suo spirito. Quello spirito “spiegava” la nostra intelligenza, almeno grammaticalmente. L’invenzione dell’ingegneria idraulica nel III secolo a.C. avrebbe poi portato alla popolarità di un modello idraulico dell’intelligenza umana, l’idea che il flusso di diversi fluidi nel corpo, cioè gli “umori”, rappresentasse il nostro funzionamento sia fisico che mentale. La metafora idraulica è persistita per più di 1.600 anni, tra l’altro, ostacolando la pratica medica per tutto il tempo.[11]

Seguendo lo schema di Zarkadakis [12] inerente alle metafore che la nostra civiltà avrebbe utilizzato per descrivere il cervello, nel 500’ sarebbero stati ideati automi alimentati da molle e ingranaggi che, alla fine, avrebbero ispirato importanti pensatori come René Descartes ad affermare che noi umani fossimo macchine complesse. Poi, nel 600’, in particolar modo il filosofo Thomas Hobbes avrebbe suggerito che il pensiero nasca da piccoli movimenti meccanici nel cervello. Nel 700’, le scoperte sull’elettricità e la chimica portarono a nuove teorie sull’intelligenza umana, ancora una volta, in gran parte di natura metaforica. A metà dell’800, ispirato dai recenti progressi nelle comunicazioni, il fisico Hermann von Helmholtz avrebbe paragonato il cervello a un telegrafo. Nella delucidazione di Zarkadakis, ogni metafora rifletteva il pensiero più avanzato dell’epoca che l’aveva generata.[13] Come sarebbe stato prevedibile utilizzando il paradigma di Zarkadakis, solo pochi anni dopo l’alba della tecnologia informatica negli anni ’40, si diceva già che il cervello funzionasse come un computer, con il ruolo di hardware fisico svolto dal cervello stesso e che i nostri pensieri fungessero da software. L’evento fondamentale che avrebbe lanciato quella che oggi è ampiamente chiamata “scienza cognitiva” è stata la pubblicazione di Language and Communication (1951) [14] dello psicologo George Miller. Miller avrebbe proposto che il mondo mentale potesse essere studiato, rigorosamente, utilizzando concetti della teoria dell’informazione, del calcolo e della linguistica.

Stando a studiosi come Robert Epstein [15], questo tipo di pensiero che stabiliva un rapporto di rispecchiamento tra cervello e computer sarebbe stato portato alla sua massima espressione nel saggio The Computer and the Brain (1958) [16], in cui il matematico John von Neumann affermava, categoricamente, che la funzione del sistema nervoso umano fosse “prima facie digitale”. Sebbene riconoscesse che in realtà si sapeva poco sul ruolo svolto dal cervello nel ragionamento e nella memoria umani, tracciò un parallelo dopo l’altro tra i componenti delle macchine informatiche dell’epoca e i componenti del cervello umano.

All’inizio degli anni 60’, verosimilmente spinto dai successivi sviluppi sia nella tecnologia informatica che nella ricerca sul cervello, si sviluppò gradualmente un ambizioso sforzo multidisciplinare per comprendere l’intelligenza umana, saldamente radicato nell’idea che noi umani siamo, come i computer, elaboratori di informazioni. Questo sforzo ora coinvolgerebbe migliaia di ricercatori, consumando miliardi di euro di finanziamenti, e avrebbe generato una vasta letteratura composta da articoli e libri sia tecnici che tradizionali. Il libro di Ray Kurzweil How to Create a Mind: The Secret of Human Thought Revealed (2013) [17], esemplificherebbe questa prospettiva, speculando sugli “algoritmi” del cervello, su come il cervello “elaborerebbe i dati” e persino su come assomiglierebbe, sebbene superficialmente, a circuiti integrati nella sua struttura. La metafora dell’intelligenza umana come elaborazione di informazioni (Information Processing) ora domina il pensiero umano, sia nelle strade che nel cosiddetto ambito scientifico. Si potrebbe asserire che oggi non esista alcuna forma di discorso sul comportamento umano intelligente che proceda senza utilizzare questa metafora, proprio come nessuna forma di discorso sul comportamento umano intelligente potrebbe procedere in certe epoche e culture senza riferimento a uno spirito o divinità. La validità della metafora del cervello come elaboratore di informazione nel mondo d’oggi è normalmente data per scontata. Ma la metafora dell’elaboratore di informazione è, dopotutto come sostiene Zarkadakis [18], solo un’altra metafora, vale a dire una storia che raccontiamo per dare un senso a qualcosa che in realtà non capiamo. E come tutte le metafore che l’hanno preceduta, a un certo punto verrà sicuramente messa da parte, sostituita da un’altra metafora o, alla fine, sostituita da ciò che potrebbe essere considerato conoscenza effettiva.

A proposito del radicamento della metafora del cervello come processore di informazione, Robert Epstein riferisce che nel 2015, durante una visita a uno degli istituti di ricerca più prestigiosi del mondo [19] avrebbe sfidato i ricercatori a spiegare il comportamento umano intelligente senza fare riferimento ad alcun aspetto della metafora dell’elaborazione di informazione. Non sarebbero stati in grado di farlo e quando Epstein avrebbe cortesemente sollevato il problema nelle successive comunicazioni via e-mail, ancora mesi dopo non ebbero nulla da offrire. Avrebbero effettivamente visto il problema, non lo avrebbero liquidato come una sfida banale ma non potevano offrire un’alternativa. In altre parole, la metafora del cervello come un elaboratore di informazione si sarebbe talmente radicata nel pensiero comune e degli studiosi che l’utilizzo di un tale linguaggio impossibilita di guardare oltre.

La logica errata della metafora del processore di informazione

Stando allo stesso Epstein [20], la logica errata della metafora del processore di informazione sarebbe abbastanza facile da affermare, si baserebbe su un sillogismo errato articolato con due premesse ragionevoli e una conclusione errata. Il ragionamento dimostrativo in questione si svolgerebbe nel modo seguente. Premessa ragionevole #1: tutti i computer sono in grado di comportarsi in modo intelligente. Premessa ragionevole #2: tutti i computer sono elaboratori di informazioni. Conclusione errata: tutte le entità in grado di comportarsi in modo intelligente sono elaboratori di informazioni. [21] Mettendo da parte il linguaggio formale, l’idea che gli esseri umani debbano essere elaboratori di informazioni solo perché i computer sono elaboratori di informazioni sarebbe semplicemente stupida, e quando, un giorno, la metafora del processore di informazione sarà finalmente abbandonata, sarà quasi certamente vista così dagli storici, proprio come ora consideriamo sciocche le metafore idrauliche e meccaniche riguardanti il cervello.

Certamente che la metafora del cervello quale elaboratore di informazione può essere giudicata sciocca quando si accede ad una epistemologia articolata della nostra conoscenza culturale del cervello umano, tuttavia, proprio per la sua pervasiva popolarità, possiamo interrogarci sul paradosso riguardo la sua futilità e la sua reputazione. Cosa impedirebbe spazzarla via dal pensiero mainstream e dai sostenitori della cosiddetta scienza? Potremmo perfino chiederci se ci sia proprio un modo per comprendere l’intelligenza umana senza appoggiarsi a una fragile stampella intellettuale. Forse ancora risulterebbe più difficile interrogarci se non stiamo a pagare un qualche prezzo per appoggiarci così perdutamente a questa particolare stampella per così tanto tempo. La metafora del cervello elaboratore di informazione, dopo tutto, ha addirittura guidato per decenni il pensiero di un gran numero di ricercatori in molteplici campi. Ma a quale prezzo?

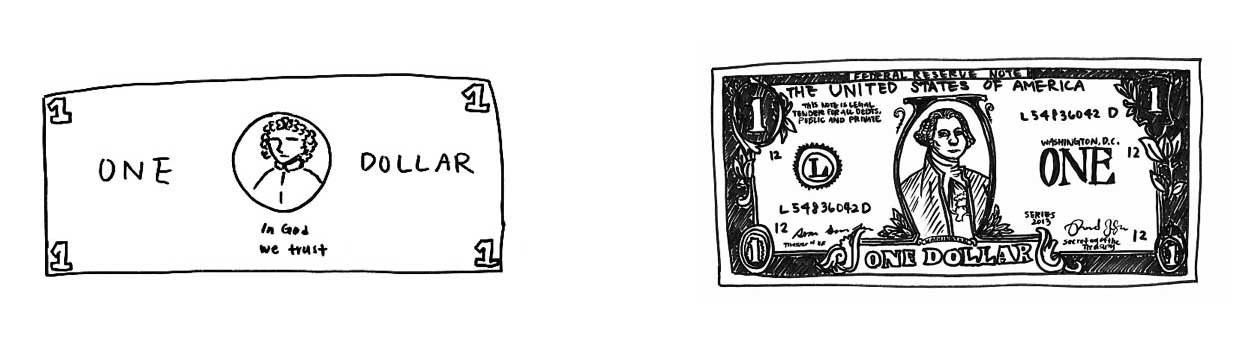

Esplorando questo eventuale costo della metafora del cervello come elaboratore di informazione, Epstein [22] riferisce che nel corso degli anni come accademico della materia avrebbe ripetutamente svolto un esercizio in classe chiedendo ad uno studente volontario di disegnare, sulla lavagna in aula, un’immagine, il più dettagliata possibile, di una banconota, nello specifico di una banconota di un dollaro statunitense. Una volta che lo studente avrebbe finito Epstein avrebbe coperto il disegno con un foglio di carta, avrebbe poi preso una reale banconota del suo portafoglio, l’avrebbe attaccata alla lavagna e avrebbe chiesto allo studente di ripetere il compito stavolta guardando al modello. Quando lo studente avrebbe finito, avrebbe tolto la copertina dal primo disegno e avrebbe chiesto alla classe di commentare le differenze. Il risultato di questo esperimento è abbastanza stupefacente e merita di essere illustrato con entrambi i disegni, uno eseguito “a memoria” e l’altro copiando il modello. Ecco il risultato che rende un’idea emblematica del problema.

Come si può vedere, il disegno fatto in assenza della banconota da un dollaro è lontano dai particolari contenuti rispetto al disegno fatto imitando un esemplare, anche se la persona che lo avrebbe disegnato avrebbe, effettivamente, visto una banconota da un dollaro migliaia di volte. Ma ciò che Epstein vorrebbe illustrarci con questa storia del disegno della banconota sarebbe proprio che noi non abbiamo una “rappresentazione” della banconota “archiviata” in un “registro di memoria” nel nostro cervello per cui non potremmo “recuperarla” e usarla per realizzare il disegno in questione. Stando a Epstein [23] nemmeno mille anni di neuroscienze riuscirebbero mai a localizzare una “rappresentazione” di una banconota di qualsiasi valuta “archiviata” all’interno del cervello umano per il semplice motivo che il cervello non è né funziona in modo simile ad un computer.

Numerosi studi sul cervello, come quelli di Asaf Gilboa, Gordon Winocur, Cheryl Grady, Stephanie Hevenor e Morris Moscovitch [24], ci dicono, infatti, che aree multiple e talvolta ampie del cervello sarebbero spesso coinvolte perfino nei compiti di memoria più banali. Quando sarebbero coinvolte forti emozioni, milioni di neuroni possono diventare più attivi. Uno studio del 2016 [25] sui sopravvissuti a un incidente aereo condotto dal neuropsicologo dell’Università di Toronto Brian Levine ed altri, volto a documentare quest’ipotesi, nei sopravvissuti partecipanti, ricordando l’incidente, l’attività neurale sarebbe aumentata nell'”amigdala, nel lobo temporale mediale, nella linea mediana anteriore e posteriore e nella corteccia visiva”. Tuttavia, nella prospettiva di questi studiosi, l‘idea, avanzata da diversi cosiddetti scienziati, che suggerisce che i ricordi specifici siano in qualche modo immagazzinati nei singoli neuroni sarebbe assurda. Semmai, un tale modello non farebbe che spingere il problema della memoria ad un livello ancora più impegnativo: come e dove, dopotutto, la memoria sarebbe archiviata o immagazzinata nella cellula?

Con queste precedenti considerazioni potremmo chiederci cosa succede, effettivamente, quando qualcuno di noi cerca di riprodurre una banconota di qualsiasi taglia nella sua assenza. Se nessuno di noi avesse mai visto prima una banconota del disegno richiesto nello esperimento, il nostro primo disegno probabilmente non sarebbe stato affatto simile al secondo disegno. Al tale proposito si potrebbe ipotizzare che, avendo già visto delle banconote, la persona che avrebbe eseguiti i disegni riportati da Epstein in qualche modo aveva fatto esperienza di osservazione. Nello specifico, il suo cervello sarebbe stato modificato in un modo che gli avrebbe permesso di visualizzare la banconota in questione, cioè di rivivere l’esperienza di vedere una banconota del genere, almeno in un qualche modo.

Nella proposta di Epstein, la differenza tra i due diagrammi starebbe a ricordarci che visualizzare qualcosa (cioè vedere qualcosa in sua assenza) sarebbe un processo cognitivo molto meno preciso che vedere qualcosa in sua presenza. Questo sarebbe il motivo per cui siamo molto più bravi a riconoscere che a ricordare. Quando ricordiamo qualcosa dobbiamo cercare di rivivere un’esperienza ma quando riconosciamo qualcosa, dobbiamo semplicemente essere consapevoli del fatto che abbiamo già avuto quest’esperienza percettiva.

Forse si potrebbe respingere questo ragionamento argomentando che la persona che aveva realizzato il disegno aveva sì visto banconote dalla taglia in questione ma non aveva mai fatto uno sforzo deliberato per “memorizzarne” i dettagli. Se l’avesse fatto, si potrebbe ribattere, avrebbe potuto, presumibilmente, disegnare la seconda immagine senza che fosse presente la banconota. Anche in questo caso, però, nessuna immagine della banconota in questione era stata in alcun modo “immagazzinata” nel cervello della persona che eseguì il disegno. Ciò che sarebbe accaduto, stando a Epstein [26], sarebbe che, semplicemente, chi avrebbe realizzato il disegno era diventata una persona più preparata a tratteggiarlo con precisione, proprio come, attraverso la pratica, un pianista diventa più abile nel suonare un concerto senza, in qualche modo, copiare lo spartito dentro di sé.

Teoria del comportamento umano intelligente priva di metafore

Nel pensiero di Epstein [27] da questo semplice esercizio, si potrebbe iniziare a costruire la struttura di una teoria del comportamento umano intelligente priva di metafore, un’interpretazione in cui il cervello non è completamente vuoto, ma sarebbe almeno privo del bagaglio della metafora del processore di informazione. A tale proposito Epstein [28] sostiene che mentre viviamo nel mondo, siamo trasformati da una varietà di esperienze. Di particolare rilievo sarebbero (1) l’osservazione di ciò che sta accadendo intorno a noi (ad esempio, altre persone che agiscono, cicli della natura, parole e immagini su schermi); (2) l’esposizione all’associazione di stimoli non importanti (come le sirene delle navi) con stimoli importanti (come la comparsa di un’auto della polizia); (3) la punizione o la ricompensa per esserci comportati in un certo modo. Nella sua prospettiva, Epstein sostiene che diventiamo più efficaci nella nostra vita se assimiliamo in modo coerente queste esperienze, come ad esempio, se ci asteniamo dal comportarci in modi per cui siamo stati puniti, se ci comportiamo più frequentemente in modi per cui siamo stati premiati.

Nonostante i titoli fuorvianti, nessuno avrebbe davvero la minima idea di come cambi il cervello dopo che, ad esempio, abbiamo imparato a cantare una canzone o a recitare una poesia. Una cosa sarebbe certa, però, stando a Epstein: né la canzone né la poesia vi sarebbero state “immagazzinate”. Semplicemente, il cervello avrebbe fatto un’esperienza in un modo ordinato che ora ci permette di cantare la canzone o recitare la poesia in determinate condizioni. Quando siamo chiamati a esibirci, sostiene Epstein, né la canzone né la poesia vengono in alcun modo “recuperate” da nessuna parte del cervello, non più di quanto i miei movimenti delle dita vengano “recuperati” quando tocco con il dito la tastiera mentre scrivo. Cantiamo o recitiamo semplicemente, non è necessario il recupero.

Anni fa, nel 2012, Epstein [29] in uno scambio di idee con il neuroscienziato Eric Kandel, vincitore di un Nobel per aver identificato alcuni dei cambiamenti chimici che avvengono nelle sinapsi neuronali dell’Aplysia (una lumaca marina) dopo che avrebbe imparato qualcosa, chiese quanto tempo, stando alle sue considerazioni, sarebbe ancora necessario per capire come funziona la memoria umana. Kandel avrebbe rapidamente risposto: “Cento anni”. A quanto riferito da Epstein sull’episodio non avrebbe pensato di chiedergli se pensava che la metafora del cervello come processore di informazioni stesse rallentando le neuroscienze. Al riguardo, stando a Epstein, alcuni neuroscienziati stanno davvero cominciando a pensare che tale metafora non sia indispensabile. Al riguardo, alcuni dei cosiddetti scienziati cognitivisti, in particolare Anthony Chemero, autore di Radical Embodied Cognitive Science (2011) [30], ora respingono completamente l’idea che il cervello umano funzioni come un computer. La visione tradizionale sarebbe che noi, come i computer, diamo un senso al mondo eseguendo calcoli su rappresentazioni mentali di esso, ma Chemero e altri descrivono un altro modo di comprendere il comportamento intelligente, descrivendolo come un’interazione diretta tra gli organismi e il loro mondo.

Per rendere chiara la differenza tra l’approccio al cervello attraverso la metafora del processore di informazione e la visione che potremmo chiamare “anti-rappresentativa”, possiamo fare riferimento allo esempio fornito da Michael McBeath su Science [31] circa come i giocatori di baseball determinano dove correre per prendere le palle al volo. La prospettiva del cervello come processore di informazione richiede al giocatore di formulare una stima delle varie condizioni iniziali del volo della palla (la forza dell’impatto, l’angolo della traiettoria, quel genere di cose) poi di creare e analizzare un modello interno del percorso lungo il quale sarebbe probabile che la palla si muova, quindi usare quel modello per guidare e regolare continuamente i movimenti motori nel tempo per intercettare la palla. Certamente, questa spiegazione andrebbe benissimo qualora noi umani funzionassimo come fanno i computer, ma McBeath e i suoi colleghi avrebbero fornito un resoconto più semplice: per prendere la palla, il giocatore deve semplicemente continuare a muoversi in un modo che mantenga la palla in una relazione visiva costante rispetto al piatto (casa base) e lo scenario circostante (tecnicamente, in una “traiettoria ottica lineare”). Potrebbe sembrare complicato, ma in realtà sarebbe incredibilmente semplice e completamente privo di calcoli, rappresentazioni e algoritmi.

Un tale approccio sembrerebbe più coerente e naturalizzato allo studio del comportamento umano in contrasto con l’approccio dominante nelle neuroscienze cognitive e tuttavia le principali scienze cognitive continuano a crogiolarsi acriticamente nella metafora del cervello come un processore di informazione. Alcuni dei pensatori più influenti del mondo hanno perfino fatto grandiose previsioni sul futuro dell’umanità che dipendono dalla validità della metafora.[32] Infatti, una previsione fatta dal futurista Kurzweil, dal fisico Stephen Hawking e dal neuroscienziato Randal Koene, sarebbe che, poiché la coscienza umana è, presumibilmente, come il software di un computer, presto sarà possibile scaricare le nostre menti umane su un computer, nei circuiti di cui diventeremo immensamente potenti intellettualmente e, molto probabilmente, immortali. Questo concetto ha guidato la trama del film distopico Transcendence (2014) con Johnny Depp nei panni dello scienziato simile a Kurzweil la cui mente è stata scaricata su Internet, con risultati disastrosi per l’umanità. Fortunatamente, sostiene Epstein [33], poiché la metafora del cervello come processore di informazione non sarebbe da considerarsi nemmeno minimamente valida, non dovremo mai preoccuparci di una mente umana che impazzisce nel cyberspazio. Inoltre, stando a lui, non raggiungeremo mai l’immortalità attraverso il download. Ciò non sarebbe dovuto solo all’assenza del software della coscienza nel cervello. Ci sarebbe un problema più profondo qui, chiamiamolo il problema dell’unicità, che risulta sia stimolante che deprimente.

Poiché dall’approccio al comportamento intelligente come un’interazione diretta tra gli organismi e il loro mondo, nel cervello non esisterebbero né “banche di memoria” né “rappresentazioni” di stimoli, e poiché tutto ciò che sarebbe richiesto per funzionare nel mondo sarebbe che il cervello si strutturi, in modo ordinato, come risultato delle nostre esperienze, di conseguenza non esisterebbe ragione alcuna per credere che due di noi umani siamo strutturati allo stesso modo dalla stessa esperienza.[34] Per rendere ancora più eloquente la posizione della visione anti-rappresentativa nella descrizione del cervello, si potrebbe asserire che se due amici assistessero allo stesso concerto per ascoltare la Quinta di Beethoven, i cambiamenti che si verificherebbero nel cervello di uno all’ascolto sarebbero, quasi certamente, completamente diversi dai cambiamenti che si verificherebbero nel cervello dell’altro. Quei cambiamenti, qualunque essi siano, sarebbero costruiti sulla struttura neurale unica che già esisterebbe ed ogni struttura si sarebbe sviluppata nel corso di una vita di esperienze uniche.[35]

Questo sarebbe il motivo per cui, in ambito popolare, come avrebbe dimostrato Frederic Bartlett in Remembering (1932) [36], due persone non ripeteranno mai una storia che abbiano sentito allo stesso modo e perché, nel tempo, le loro recitazioni della storia divergeranno sempre di più. Nessuna “copia” della storia viene mai realizzata; piuttosto, ogni individuo, dopo aver ascoltato la storia, la cambia in una certa misura in modo che quando gli viene richiesto di raccontare la storia in seguito possa rivivere l’esperienza dell’ascolto della storia soltanto in un modo approssimativo. Questo aspetto dell’unicità del cervello nella strutturazione delle singole esperienze potrebbe essere fonte d’ispirazione perché significherebbe che ognuno di noi sia davvero unico, non solo nel nostro corredo genetico, ma anche nel modo in cui il nostro cervello cambia nel tempo. Sarebbe anche deprimente perché rende il compito del neuroscienziato scoraggiante quasi oltre ogni immaginazione. Per ogni data esperienza, il cambiamento ordinato del cervello potrebbe coinvolgere un migliaio di neuroni, un milione di neuroni o anche l’intero cervello e, per di più, con il modello di cambiamento diverso in ogni cervello, come sostiene Epstein.[37]

La situazione, stando a Epstein, sarebbe peggio ancora. Infatti, anche se avessimo la capacità di scattare un’istantanea di tutti gli 86 miliardi di neuroni del cervello e, quindi, di simulare lo stato di quei neuroni in un computer, quel vasto schema non significherebbe nulla al di fuori del corpo del cervello che lo avrebbe prodotto. Questo sarebbe forse il modo più eclatante in cui la metafora riguardo al cervello quale processore di informazione avrebbe distorto il nostro pensiero sul funzionamento umano. In tal senso, mentre i computer memorizzano copie esatte dei dati, copie che possono persistere invariate per lunghi periodi di tempo, anche se l’alimentazione venisse spenta, il cervello manterrebbe il nostro intelletto solo finché rimane in vita. Non c’è nessun interruttore on-off. O il cervello continua a funzionare o siamo scomparsi. Inoltre, come ha sottolineato il neurobiologo Steven Rose in The Future of the Brain [38] un’istantanea dello stato attuale del cervello potrebbe anche essere priva di significato se non conoscessimo l’intera storia della vita del proprietario di quel cervello – forse anche del contesto sociale in cui sarebbe stato cresciuto ed educato.

Complessità dell’interpretazione teoretica circa l’intelligenza

Quest’ultimo accenno al termine di questa breve argomentazione circa l’obsolescenza della metafora del cervello come un computer, ci rende l’idea della complessità dell’interpretazione teoretica circa l’intelligenza. Per comprendere unicamente le basi di come il cervello manterrebbe l’intelletto umano, potremmo aver bisogno di conoscere non solo lo stato attuale di tutti gli 86 miliardi di neuroni e le loro 100 trilioni di interconnessioni, non solo le diverse forze con cui sarebbero connessi, e non solo gli stati di più delle 1.000 proteine che, stando all’euristica disponibile, esisterebbero in ogni punto di connessione, ma perfino come l’attività del cervello, momento per momento, contribuirebbe all’integrità del sistema. Si aggiunga a ciò l’unicità di ogni cervello, determinata in parte dall’unicità della storia della vita di ogni persona, e la previsione di Kandel, circa i cento anni per capire come funzioni la memoria umana, inizia a suonare eccessivamente ottimista. In un recente editoriale sul New York Times [39], il neuroscienziato Kenneth Miller ha suggerito che ci vorranno “secoli” solo per capire la connettività neuronale di base.

Nel frattempo, vengono raccolte ingenti somme di denaro per la ricerca sul cervello, basata in alcuni casi su idee errate e promesse che non possono essere mantenute. L’esempio più clamoroso di neuroscienza andato storto, documentato in un rapporto su Scientific American [40], riguardo l’Human Brain Project di quasi 1,3 miliardi di euro lanciato dall’Unione Europea nel 2013. [41] Stando alla narrativa convenzionale, convinti dal carismatico Henry Markram di poter creare una simulazione dell’intero cervello umano su un supercomputer entro il 2023, e che un tale modello avrebbe rivoluzionato il trattamento del morbo di Alzheimer e di altri disturbi, i funzionari dell’UE hanno finanziato il suo progetto praticamente senza restrizioni. Dopo meno di due anni, il progetto si è trasformato in un “relitto cerebrale” e a Markram è stato chiesto di dimettersi.[42]

Siamo organismi, non computer. Facciamocene una ragione. Andiamo avanti con il compito di cercare di capire noi stessi, ma senza essere appesantiti da inutili bagagli intellettuali. La metafora del cervello quale processore di informazioni ha avuto una corsa di mezzo secolo, producendo poche, se non nessuna, intuizioni lungo la strada. Come avrebbe detto già nel 2016 Robert Epstein, è giunto il momento di premere il tasto CANCELLA a questa narrativa del cervello come computer e degli algoritmi come intelligenza.[43] Il comportamento intelligente rimane un’interazione diretta tra gli organismi viventi e il loro ambiente.

______________Note _________________

1.Robert Epstein. The empty brain. AEON, 18 May 2016

2. Ibidem

3. Ibidem

4. Ibidem

5. Epstein, Robert; Roberts, Gary; Beber, Grace. Parsing the Turing Test: Philosophical and Methodological Issues in the Quest for the Thinking Computer (co-editor), 2009

6. Ibidem

7. Ibidem

8. Ibidem

9. Mark Johnson e George Lakoff. Metafora e vita quotidiana, Milano, Bompiani, 2005

10. George Zarkadakis. In our own image. Rider Books, UK, 2015

11. Robert Epstein. op. cit. 2016

12. Robert Epstein. op. cit. 2016

13. Ibidem

14. George Miller. Language and Communication. McGraw-Hill, NY, 1951 / Linguaggio e comunicazione. La Nuova Italia, Firenze, 1971

15. Robert Epstein. op. cit. 2016

16. John von Neumann. The computer and the brain. Yale University Press, 1958 / Il computer e il cervello. Bompiani, 1999

17. Ray Kurzweil. How to create a mind: the secret of human thought revealed. Penguin Books, 2013

18. George Zarkadakis, op. cit. 2015

19. Robert Epstein. The empty brain. AEON, 18 May 2016

20. Epstein, Robert; Roberts, Gary; Beber, Grace. op. cit. 2009

21. Robert Epstein. The empty brain. AEON, 18 May 2016

22. Ibidem

23. Ibidem

24. Asaf Gilboa, Gordon Winocur, Cheryl L. Grady, Stephanie J. Hevenor, Morris Moscovitch, Remembering Our Past: Functional Neuroanatomy of Recollection of Recent and Very Remote Personal Events, Cerebral Cortex, Volume 14, Issue 11, Pages 1214–1225. November 2004

25. Palombo, D. J., McKinnon, M. C., McIntosh, A. R., Anderson, A. K., Todd, R. M., & Levine, B. The Neural Correlates of Memory for a Life-Threatening Event: An fMRI Study of Passengers from Flight AT236. Clinical Psychological Science, 4(2), 312–319, 2016

26. Robert Epstein. The empty brain. AEON, 18 May 2016

27. Ibidem

28. Ibidem

29. Robert Epstein. Brutal truths about the ageing brain. Tale of the scans, a mind in decline. Discover Magazine. Sep 20, 2012

30. Anthony P. Chemero. Radical Embodied Cognitive Science. MIT Press, 201

31. McBeath MK, Shaffer DM, Kaiser MK. How baseball outfielders determine where to run to catch fly balls. Science. 268(5210):569-73, Apr 28, 1995

32. Robert Epstein. The empty brain. AEON, 18 May 201

33. Ibidem

34. Ibidem

35. Ibidem

36. Frederic Bartlett. Remembering: A study in experimental and social psychology. Cambridge University Press, 1932

37. Robert Epstein. The empty brain. AEON, 18 May 2016

38.Steven Rose. The Future of the Brain: The promise and perils of tomorrow’s neuroscience. Oxford University Press, 2006

39. Kenneth D. Miller. Will you ever be able to upload your brain. The New York Times, Oct. 10, 2015

40. Stefan Theil. Why the Human Brain Project Went Wrong – and How to Fix it. Scientific American. October 1, 2015

41. Per informazione veloce sulle critiche e contestazioni al progetto consultare questo link

42. Ibidem

43. Robert Epstein. The empty brain. AEON, 18 May 2016

0 commenti